볼륨의 용량이 부족해요.

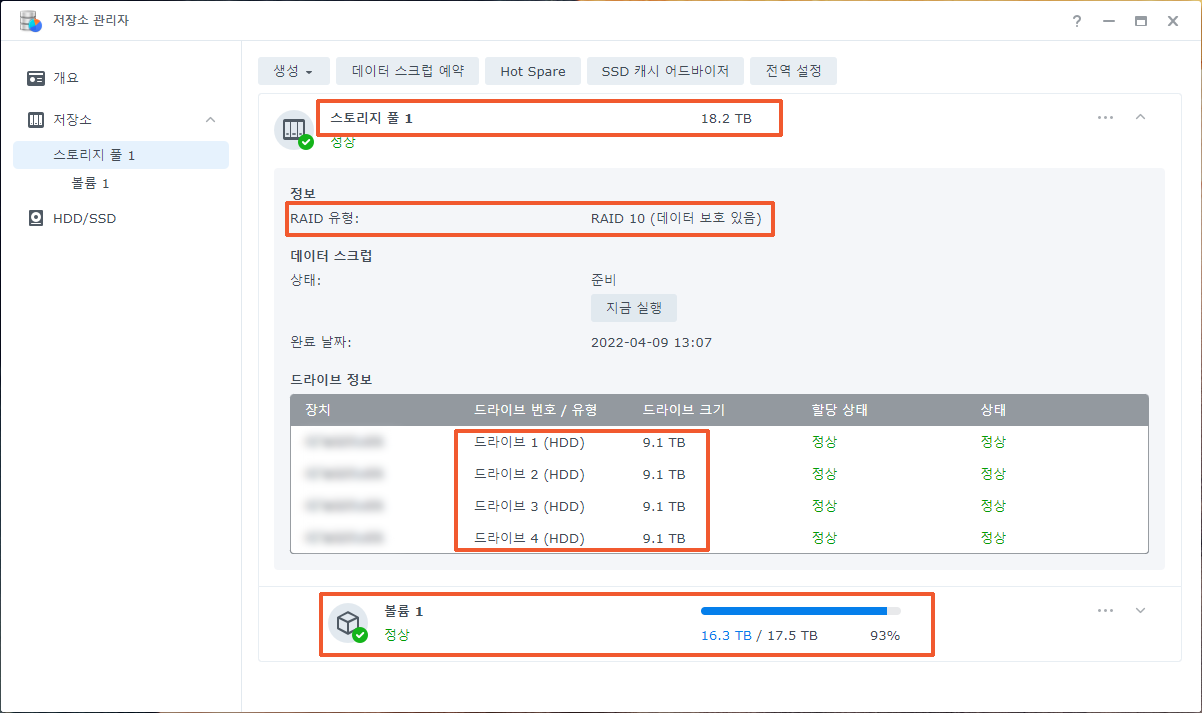

20TB 크기의 볼륨을 사용하고 있는데요. 용량을 90% 정도 사용했습니다. 1년에 5TB 정도의 데이터가 생성되는데요. 볼륨의 용량을 넉넉하게 확장하고 싶습니다. 현재 나스 두 대를 사용하고 있습니다. 시놀로지 DS920+(10TB 디스크 4개, 레이드 10) 제품을 실사용으로, 넷기어 RN424(6TB 디스크 4개, 레이드 5) 제품을 백업용으로 사용하고 있는데요. 비용 절약을 위해서 이 제품을 최대한 활용하고자 합니다.

중요한 조건이 하나 더 있는데요. 볼륨의 용량을 확장하는 동안에도 나스를 계속 사용해야 한다는 점입니다.

용량을 확장하려면 디스크를 교체하거나 추가해야 합니다.

교체와 추가중 어떤 방법을 선택할지는 나스의 현재 상태에 따라 다릅니다. 사용 중인 디스크 개수, 사용 중인 디스크 용량, 비어 있는 베이 개수, 레이드 유형, 필요한 용량 등 여러가지 상황을 고려해서 가장 좋은 방법을 선택합니다.

디스크를 교체하는 방법은 용량이 작은 디스크를 사용하고 있을 때 권장합니다. 20TB 디스크로 교체한다고 가정했을 때, 3TB~4TB 디스크에서 교체하면 5~6배의 용량 확장을 가져오므로 큰 효과를 볼 수 있습니다. 하지만 지금처럼 10TB 디스크에서 교체하면 2배 밖에 확장되지 않으므로 비용 대비 효과가 별로입니다.

비어 있는 베이가 있을 때는 디스크를 추가로 장착해서 용량을 확장합니다. 만약 비어 있는 베이가 없다면 확장 유닛(Expansion Unit DX517)을 연결하거나 나스를 더 많은 베이를 내장하고 있는 제품으로 교체해야 합니다.

확장 유닛을 사용하는 경우에는 확장 유닛에 장착한 디스크만으로 볼륨을 만드는 방법과, 나스에 장착한 디스크와 확장 유닛에 장착한 디스크를 합쳐서 볼륨을 만드는 방법이 있는데요. 후자의 방법은 사용하지 않기를 권장합니다. 하지만 전자의 방법(나스에 장착한 디스크끼리 볼륨을 만들고 확장 유닛에 장착한 디스크끼리 새로운 볼륨을 만드는 방법)은 나스에 장착한 디스크에 생성한 공유 폴더(사실상 용량을 확장해야 하는 공유 폴더)의 용량을 확장하지 못하는 단점이 있습니다.

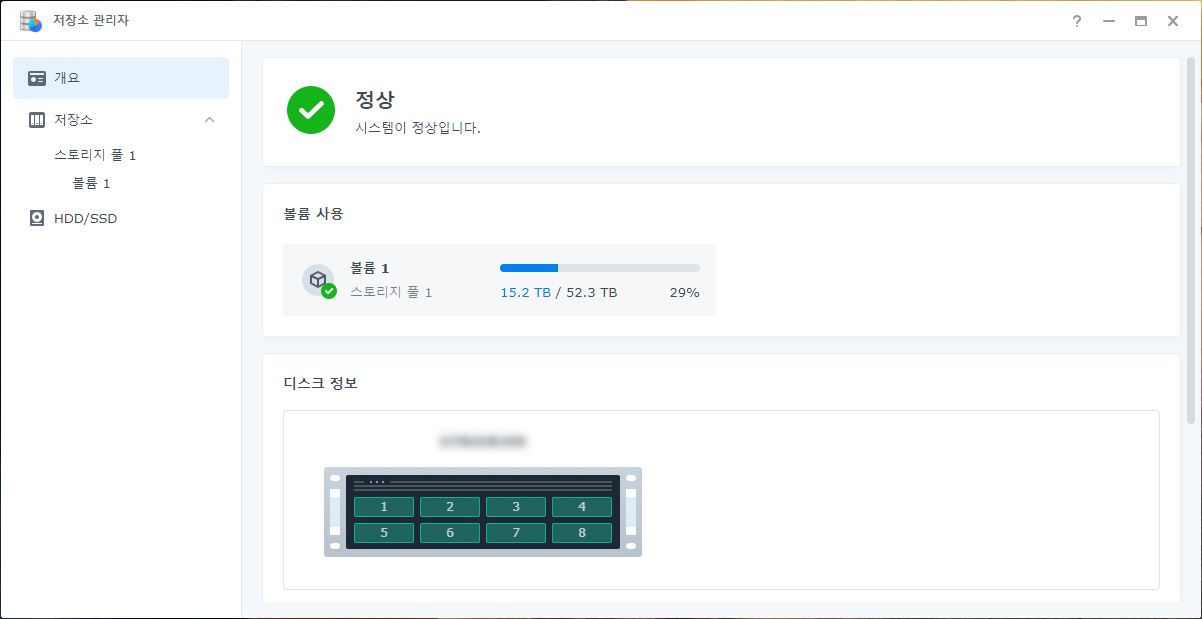

현재 상황에서 가장 좋은 방법은 8베이 나스로 교체하는 것입니다. 이 방법이 비용을 절약하고, 확장하는 동안에도 나스를 계속 사용할 수 있고, 지금 사용 중인 공유 폴더의 용량을 확장할 수 있고, 볼륨의 용량을 3배로 확장할 수 있기 때문입니다.

소요시간 : 9일 어려움 : ★★★★★

8베이 제품으로 교체합니다.

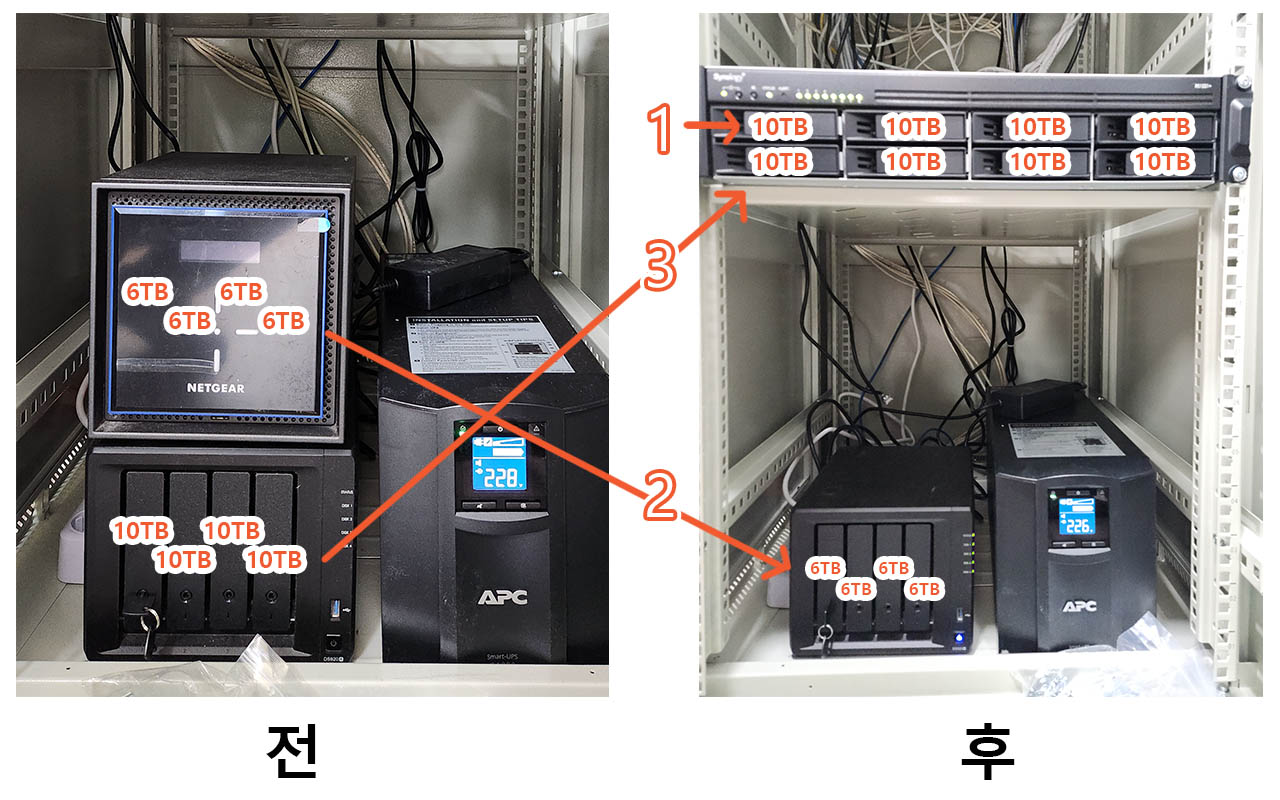

8베이 제품 RS1221+를 설치합니다. 디스크를 4개 더 장착하는 만큼 더 큰 용량의 볼륨을 사용할 수 있습니다. 지금 사용중인 나스의 레이드 유형이 “레이드 10″입니다. 안타깝게도 “레이드 10″은 디스크를 추가해도 이미 생성한 볼륨의 용량을 확장할 수 없습니다. 따라서 DS920+에서 RS1221+로의 마이그레이션은 의미가 없고, RS1221+에 새로운 스토리지 풀과 볼륨을 생성하고 데이터 옮겨야 합니다.

DS920+의 데이터를 RS1221+로 옮기는 작업이 끝나면 이제부터는 RS1221+를 실사용 나스로 사용합니다. RS1221+를 실사용 나스로 전환하는 과정에서 2시간 정도 나스 접속이 끊깁니다.

DS920+를 백업용 나스로 셋팅합니다. 비용을 절약하기 위해서 RN424에서 사용하던 디스크를 다시 사용합니다. 18TB(6TB x 4, 레이드 5) 용량이므로 하이퍼 백업에서 압축 옵션을 사용하면 앞으로 2년 정도는 백업이 가능할 것으로 생각됩니다.

모든 작업을 완료하는데 9일이 소요되었습니다. 이 기간 중에 나스 접속이 끊기는 시간은 2시간 정도입니다. 나스 접속을 끊어야 하는 작업을 평일 저녁이나 주말에 하기도 하는데요. 그러면 사실상 나스를 사용하지 못하는 시간은 없는 거나 다름없습니다.

- RS1221+ 초기 설정하기.

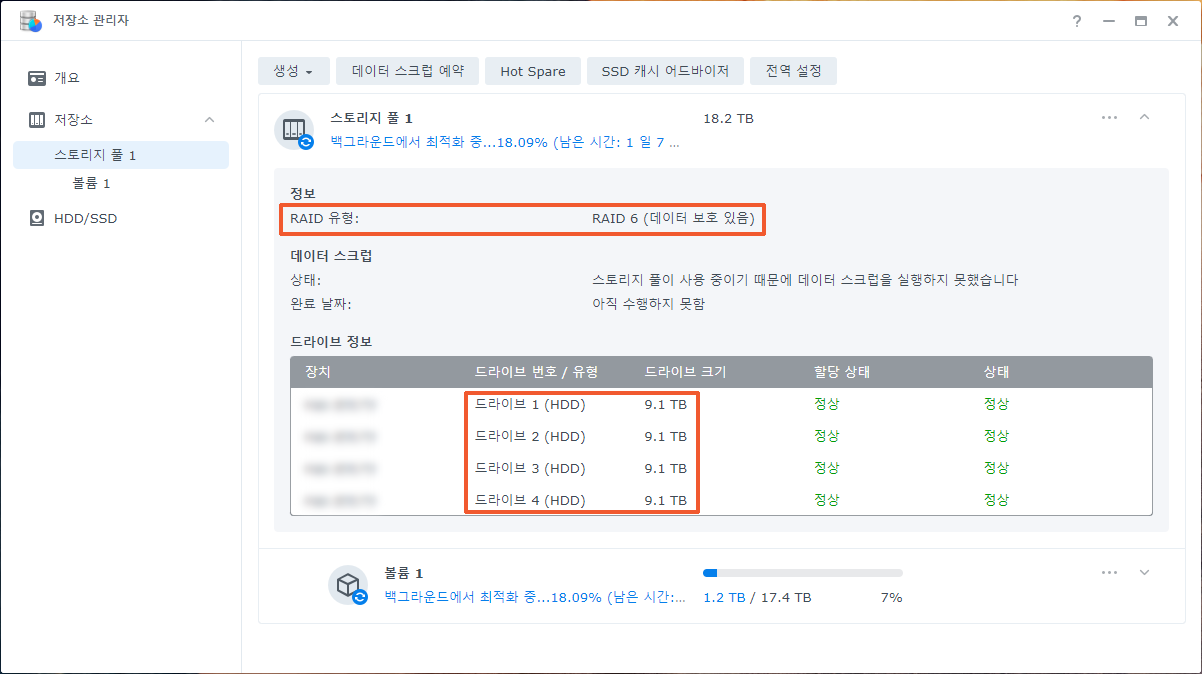

10TB 디스크(새 디스크) 4개를 장착하고 레이드 6로 설정합니다. - DS920+의 데이터와 설정 옮기기.

공유 폴더 및 나스의 설정을 RS1221+에 복사합니다. - RS1221+ 사용하기.

DS920+의 역할을 RS1221+로 대체합니다. 이제부터 RS1221+가 실사용 나스가 됩니다. - DS920+를 백업용 나스로 셋팅하기.

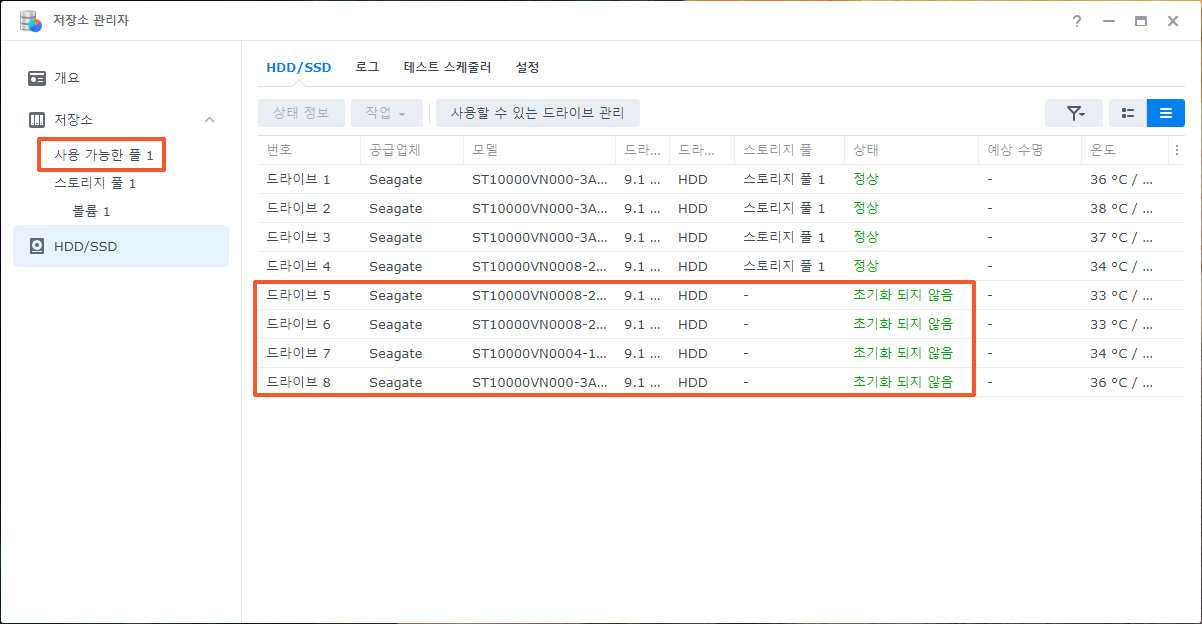

6TB 디스크(RN424에서 사용하던 디스크)를 장착하고 레이드 5로 설정합니다. - RS1221+ 백업하기.

하이퍼 백업을 사용해서 DS920+에 백업합니다. - RS1221+ 용량 확장하기.

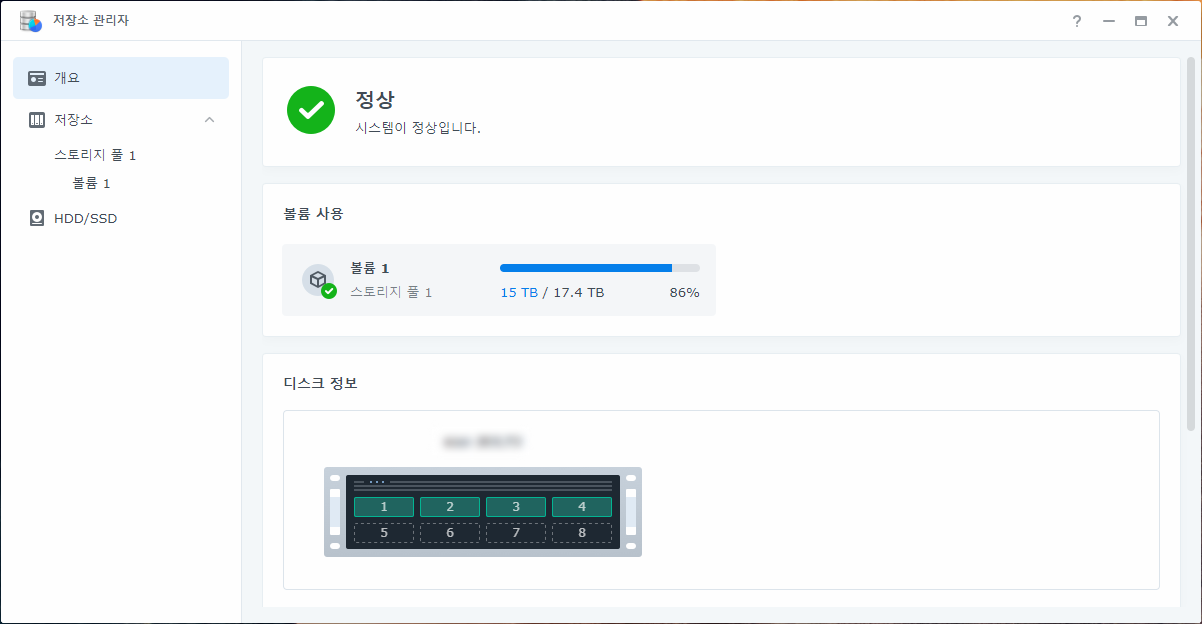

10TB 디스크(DS920+에서 사용하던 디스크)를 장착하고 볼륨의 용량을 확장합니다.

스토리지 풀의 레이드 유형은 “레이드 6″로 설정합니다. 디스크를 8개 사용할 예정이므로 “레이드 5″보다 안전한 “레이드 6″를 권장합니다.

DS920+의 공유 폴더를 모두 복사했습니다. 아이피 주소와 호스트네임 등 필요한 설정을 마치면 이제부터는 RS1221+를 사용하게 됩니다.

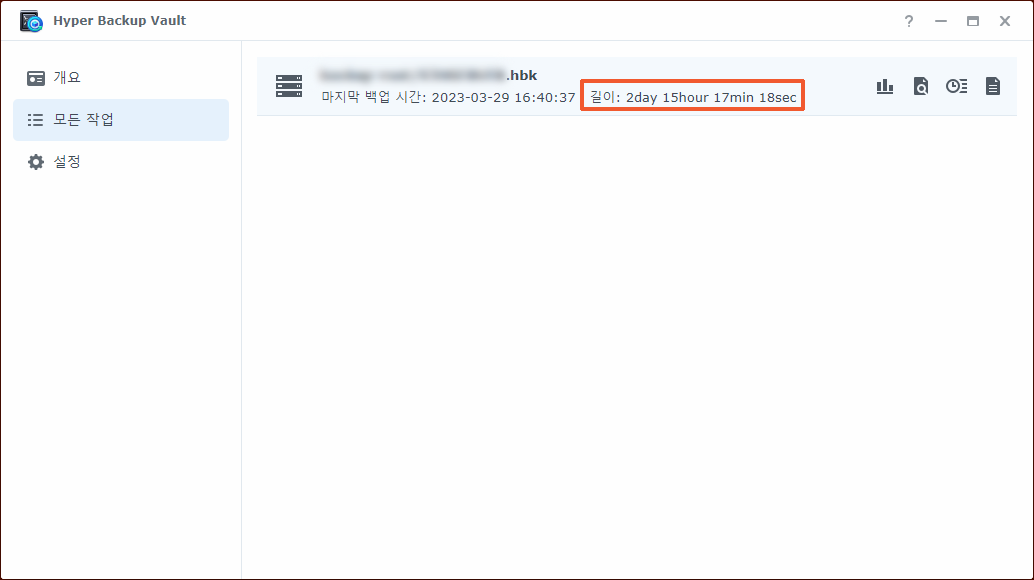

DS920+를 백업용으로 셋팅합니다. RS1221+에는 “하이퍼 백업”을 설치하고 DS920+에는 “하이퍼 백업 볼트”를 설치합니다. 15TB 용량을 최초로 백업하는데 63시간 걸렸습니다. 이후에는 1시간(백업할 파일을 검색하는데 40분, 전송하는데 20분)정도 소요됩니다.

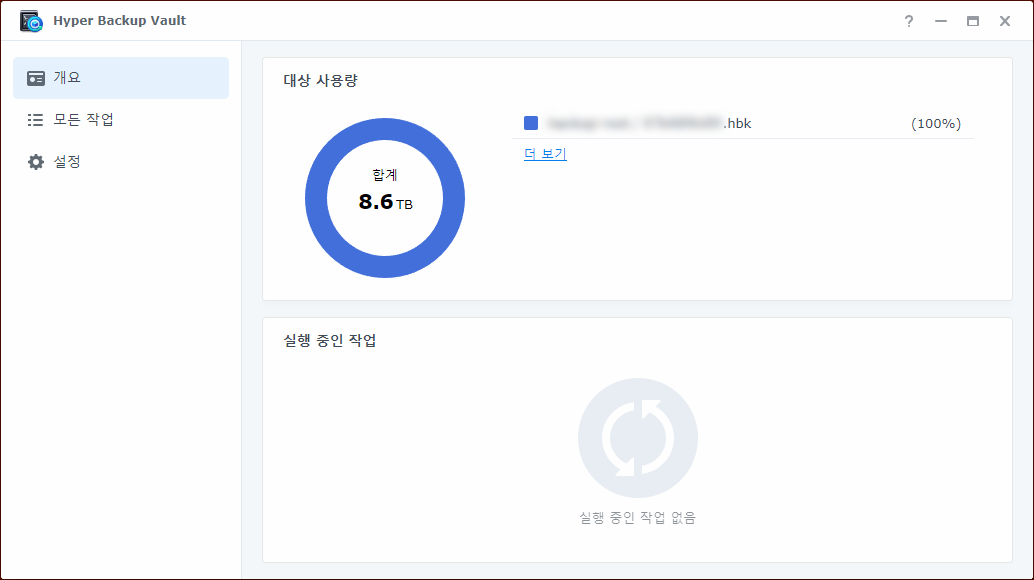

원본의 용량은 15TB지만 백업본은 8.6TB밖에 차지하지 않습니다. 한동안은 백업이 가능합니다.

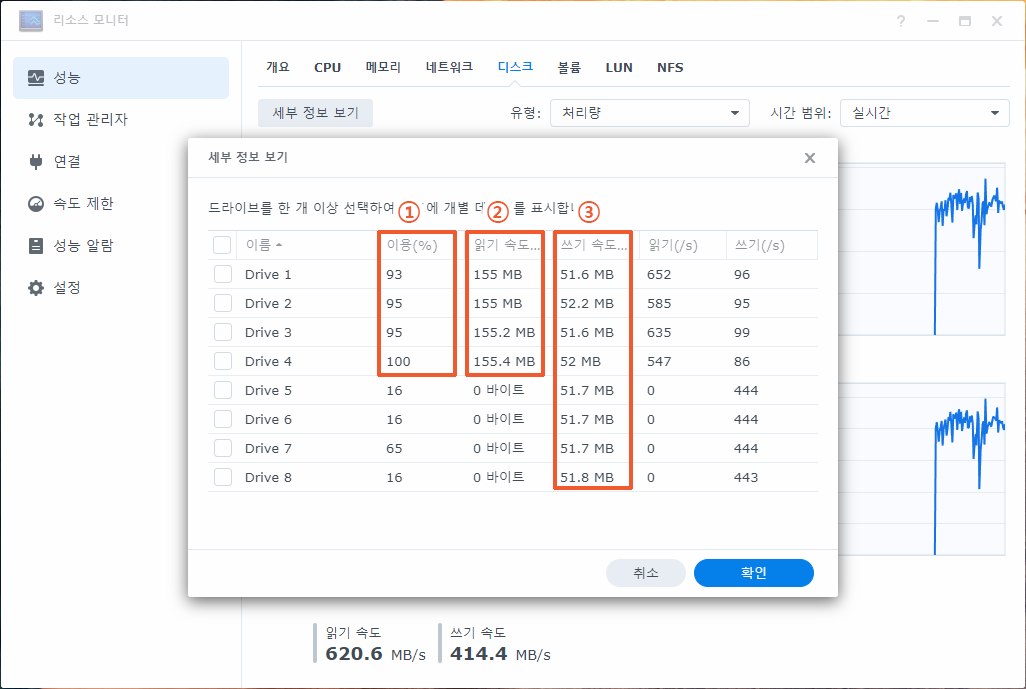

DS920+에서 사용하던 10TB 디스크 4개를 장착하고 용량을 확장합니다.

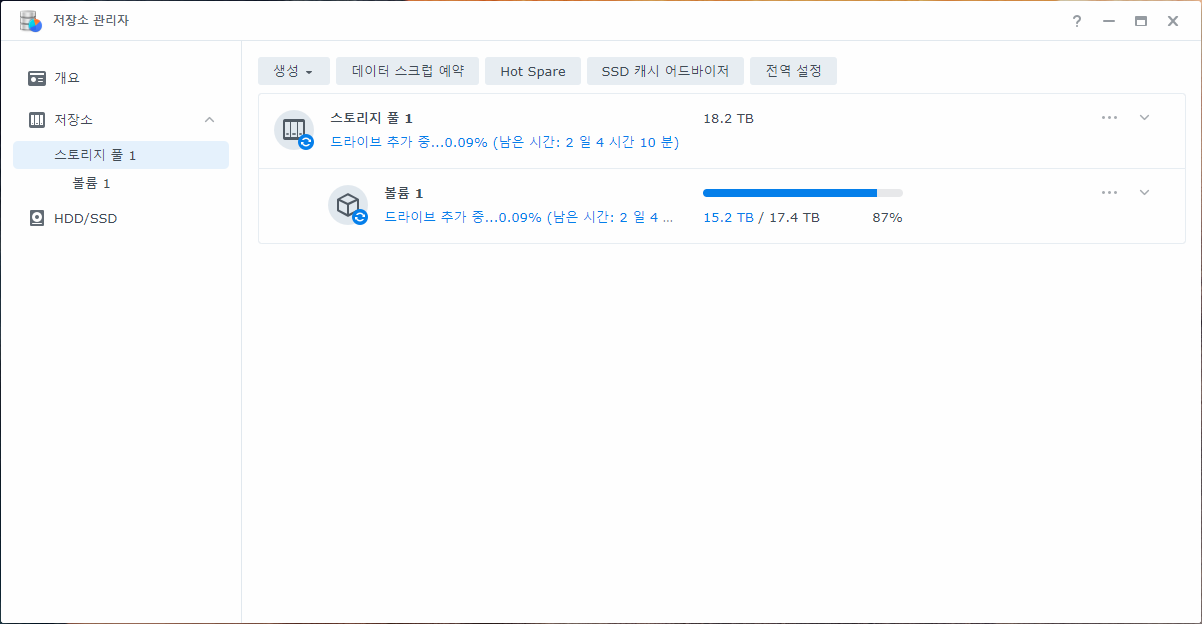

용량 확장에 소요되는 시간은 1일 21시간 정도입니다.

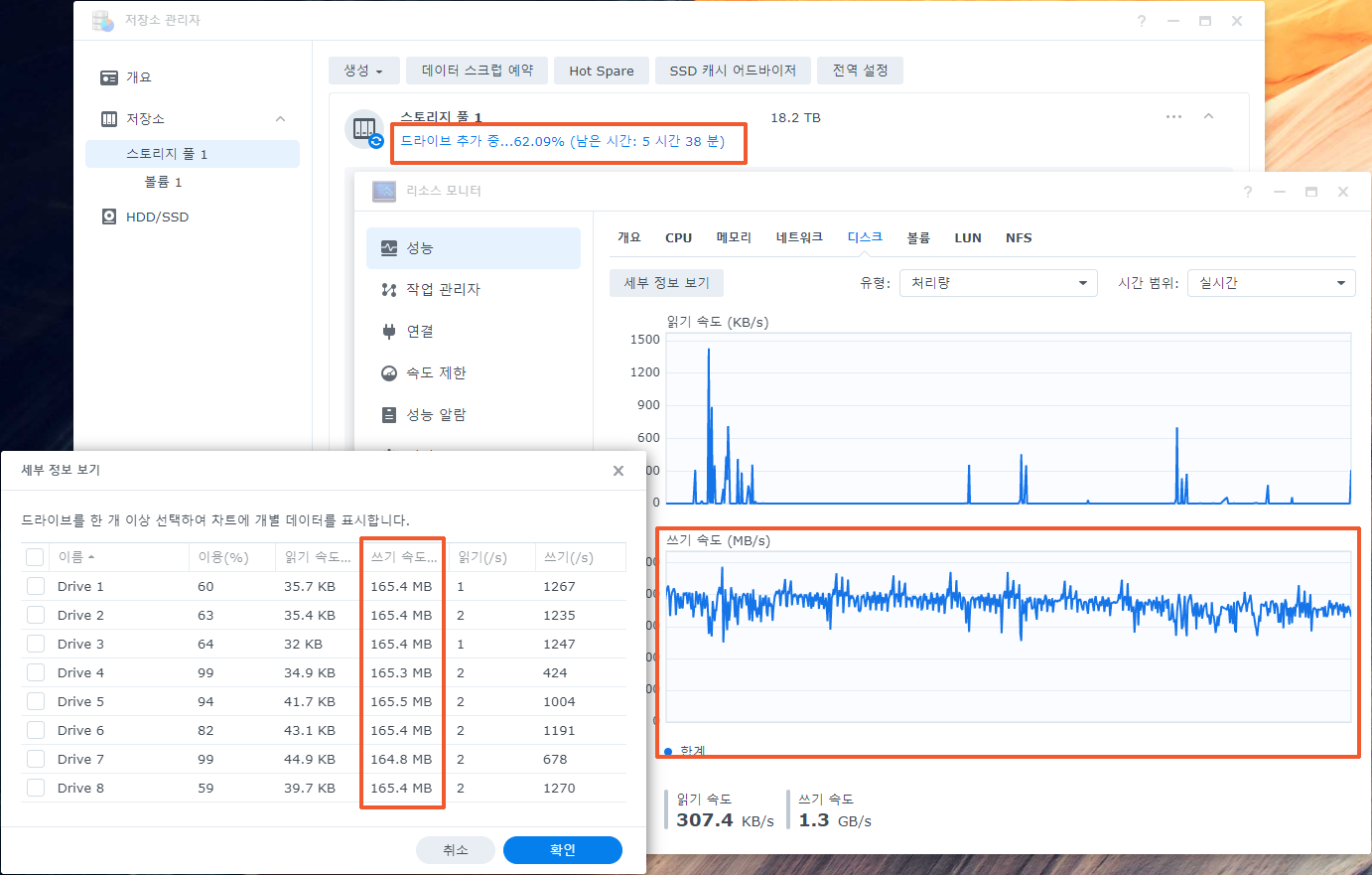

정보 시스템 2023/04/02 21:34:36 XXXX System successfully expanded [Storage Pool 1] with drive [Drive 5, Drive 6, Drive 7, Drive 8].

정보 시스템 2023/04/01 12:22:50 XXXX System starts to expand [Storage Pool 1] with drive [Drive 5, Drive 6, Drive 7, Drive 8].

①은 새 디스크입니다. ②와 ③은 사용하던 디스크입니다.

궁금하면 ↓↓↓↓

root@NAS:~# cat /proc/mdstat

Personalities : [raid1] [raid6] [raid5] [raid4] [raidF1]

md2 : active raid6 sata8p3[7] sata7p3[6] sata6p3[5] sata5p3[4] sata1p3[0] sata4p3[3] sata3p3[2] sata2p3[1]

19511425024 blocks super 1.2 level 6, 64k chunk, algorithm 2 [8/8] [UUUUUUUU]

[>....................] reshape = 0.0% (2776384/9755712512) finish=2963.2min speed=54854K/sec

md1 : active raid1 sata8p2[5] sata7p2[6] sata6p2[7] sata5p2[4] sata1p2[0] sata2p2[3] sata3p2[2] sata4p2[1]

2097088 blocks [8/8] [UUUUUUUU]

md0 : active raid1 sata8p1[5] sata7p1[6] sata6p1[7] sata5p1[4] sata1p1[0] sata2p1[3] sata3p1[2] sata4p1[1]

2490176 blocks [8/8] [UUUUUUUU]

unused devices: <none>

root@NAS:~# date

Sat Apr 1 12:25:37 KST 2023

root@NAS:~# cat /sys/block/sata[12345678]/sata[12345678]p3/stat

35056492 41748341 8263313056 429209248 2398723 33071177 283231145 64420125 37 51262490 493772251

35210031 41699711 8263678118 420839339 2305740 33101829 282732529 63262370 12 49649541 484242381

35181506 41666347 8263506830 424556125 2400643 33084662 283353457 65201017 30 50918073 489896005

34946501 41856371 8263366512 674712346 2411236 33104655 283606945 78713036 31 59229392 753607357

361 0 2740 190 61110 1788761 14798763 31474 0 22718 31644

380 0 2864 267 61097 1788777 14798770 31635 0 22910 31879

360 0 2704 145 61106 1788763 14798753 336267 0 92465 336404

398 0 2952 282 61064 1788808 14798768 36789 0 25222 37062

root@NAS:~#

root@NAS:~#

root@NAS:~#

root@NAS:~#

root@NAS:~#

root@NAS:~# date

Sat Apr 1 15:05:29 KST 2023

root@NAS:~# cat /sys/block/sata[12345678]/sata[12345678]p3/stat

40931429 409779234 11254612256 549666807 3266419 156842745 1280382259 123443555 15 60488881 673254277

40691778 410124112 11254965286 537663120 3166105 156880362 1279877163 123485729 26 58895449 661291184

41072035 409681749 11254797438 545104082 3282672 156841796 1280498891 123466626 19 60134860 668698737

40205989 410501913 11254650592 829034583 3235124 156920116 1280755083 155017282 32 68763882 984224852

427 138 4372 390 4253560 122233512 1011889717 1907509 0 1489564 1906250

478 112 4544 566 4254446 122232677 1011890044 1926968 0 1496185 1925805

374 128 3840 243 4253736 122233290 1011888691 22731248 4 6301017 22730741

495 106 4576 1041 4253926 122233183 1011888506 2963841 8 1776833 2963976

root@NAS:~# date

Sat Apr 1 15:05:56 KST 2023

root@NAS:~# cat /proc/mdstat

Personalities : [raid1] [raid6] [raid5] [raid4] [raidF1]

md2 : active raid6 sata8p3[7] sata7p3[6] sata6p3[5] sata5p3[4] sata1p3[0] sata4p3[3] sata3p3[2] sata2p3[1]

19511425024 blocks super 1.2 level 6, 64k chunk, algorithm 2 [8/8] [UUUUUUUU]

[=>...................] reshape = 5.2% (508449604/9755712512) finish=2949.3min speed=52255K/sec

md1 : active raid1 sata8p2[5] sata7p2[6] sata6p2[7] sata5p2[4] sata1p2[0] sata2p2[3] sata3p2[2] sata4p2[1]

2097088 blocks [8/8] [UUUUUUUU]

md0 : active raid1 sata8p1[5] sata7p1[6] sata6p1[7] sata5p1[4] sata1p1[0] sata2p1[3] sata3p1[2] sata4p1[1]

2490176 blocks [8/8] [UUUUUUUU]

unused devices: <none>

root@NAS:~# date

Sat Apr 1 15:06:44 KST 2023

root@NAS:~#