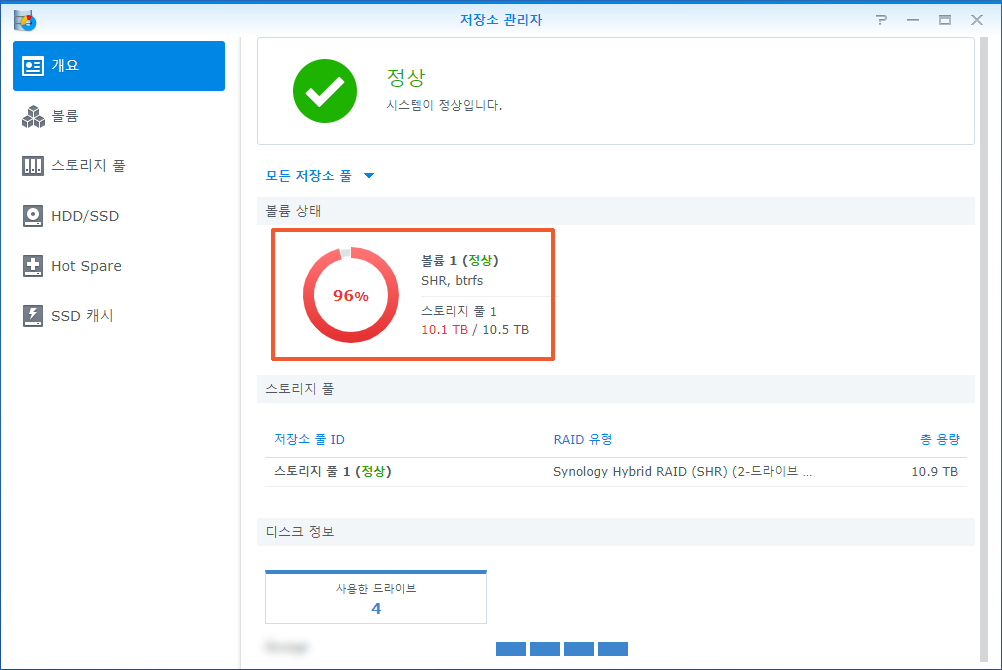

볼륨의 용량이 부족합니다.

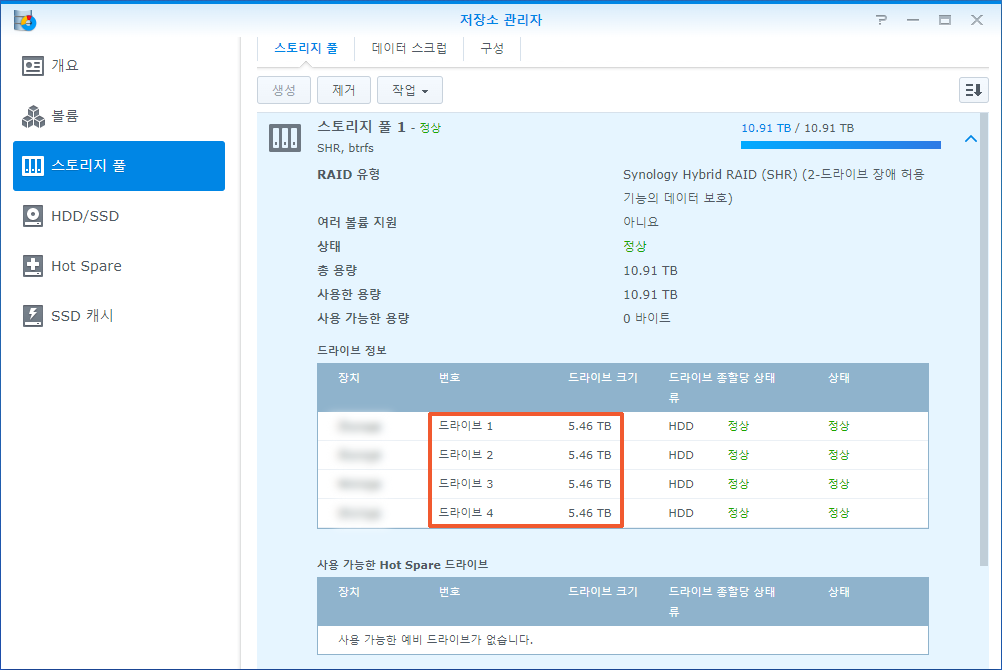

사용 가능한 용량이 부족하다는 메일이 수신됩니다. 메일이 처음 왔을 때는 사용 가능한 용량이 20%였는데요. 점점 줄어들어서 이제는 1%도 남지 않았습니다. DS918+ 제품에 6TB 디스크 4개를 SHR-2(레이드6)로 사용하고 있는데요. 디스크를 더 큰 용량으로 교체해서 볼륨의 용량을 확장하려고 합니다.

소요시간 : 4일 어려움 : ★★★★★

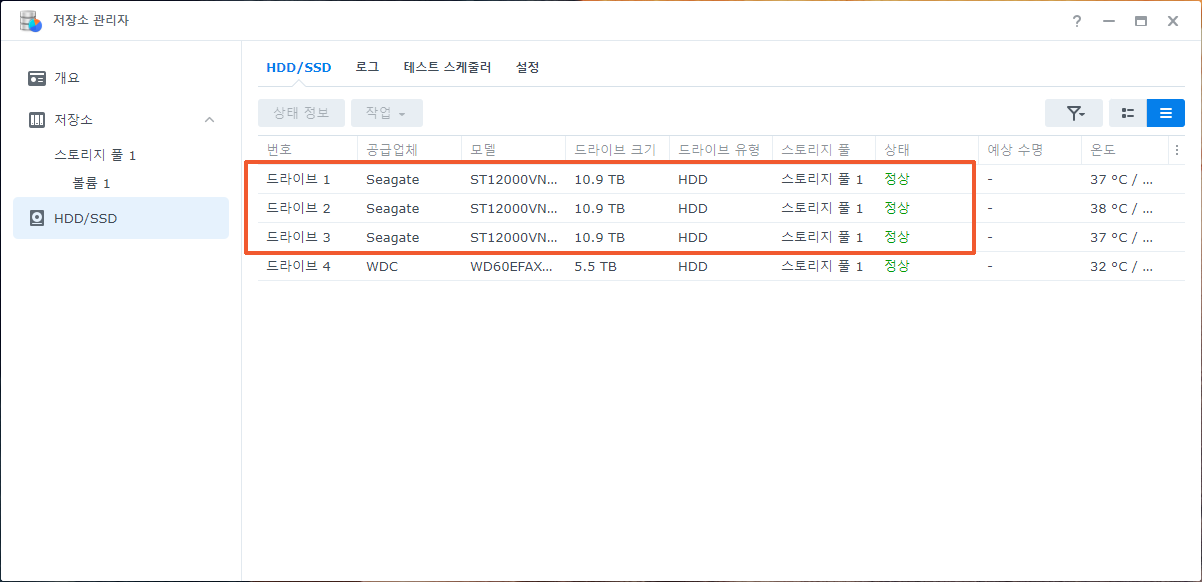

12TB 디스크로 교체합니다.

6TB 디스크를 모두 12TB로 교체합니다. 디스크의 용량이 2배로 커지므로 4개 모두 교체한 이후에는 볼륨의 용량도 2배 늘어납니다. 디스크 한 개를 교체하는데 15시간이 소요됩니다. 레이드6이므로 레이드5를 사용하는 경우보다 한결 마음 편하게 교체작업을 진행할 수 있습니다.

궁금하면 ↓↓↓↓

12TB + 12TB = 24TB

root@NAS:~# parted /dev/sda print free

Model: ATA ST12000VN0008-2P (scsi)

Disk /dev/sda: 12.0TB

Sector size (logical/physical): 512B/512B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

17.4kB 1049kB 1031kB Free Space

1 1049kB 2551MB 2550MB ext4 raid

2 2551MB 4699MB 2147MB linux-swap(v1) raid

4699MB 4840MB 142MB Free Space

5 4840MB 6001GB 5996GB raid

6001GB 6001GB 8241kB Free Space

6 6001GB 12.0TB 5993GB raid

12.0TB 12.0TB 6147MB Free Space

root@NAS:~# cat /proc/mdstat

Personalities : [raid1] [raid6] [raid5] [raid4] [raidF1]

md3 : active raid6 sdd6[3] sdc6[2] sdb6[1] sda6[0]

11704908672 blocks super 1.2 level 6, 64k chunk, algorithm 2 [4/4] [UUUU]

md2 : active raid6 sdd5[4] sdc5[7] sdb5[6] sda5[5]

11711382912 blocks super 1.2 level 6, 64k chunk, algorithm 2 [4/4] [UUUU]

md1 : active raid1 sdd2[3] sdc2[2] sdb2[1] sda2[0]

2097088 blocks [4/4] [UUUU]

md0 : active raid1 sdd1[3] sdc1[2] sdb1[1] sda1[0]

2490176 blocks [4/4] [UUUU]

unused devices: <none>

root@NAS:~# lvm pvs

PV VG Fmt Attr PSize PFree

/dev/md2 vg1000 lvm2 a-- 10.91t 0

/dev/md3 vg1000 lvm2 a-- 10.90t 0

root@NAS:~# lvm vgs

VG #PV #LV #SN Attr VSize VFree

vg1000 2 1 0 wz--n- 21.81t 0

root@NAS:~# lvm lvs

LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert

lv vg1000 -wi-ao---- 21.81t

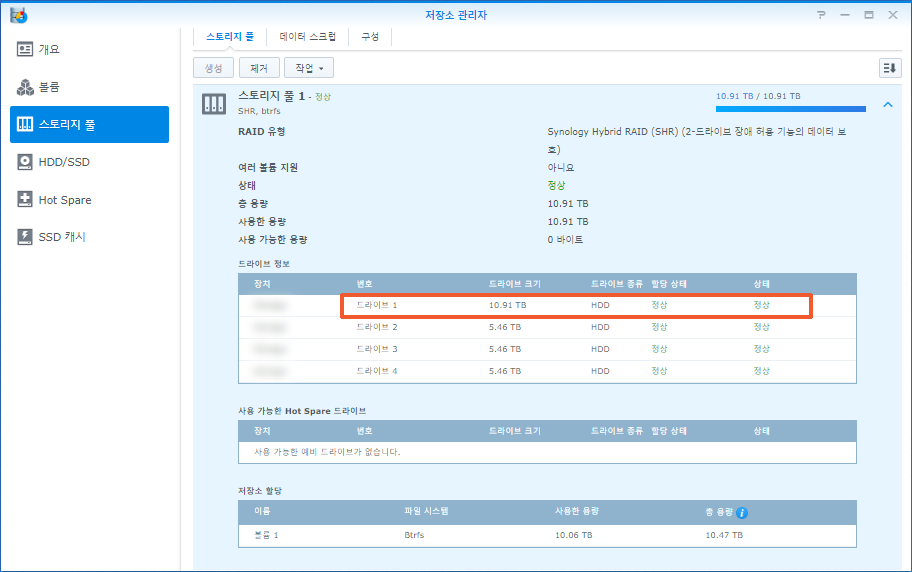

root@NAS:~# SHR을 사용하므로 12TB 디스크에는 교체하기 전 디스크(6TB 디스크)와의 차이(6TB)만큼 추가적인 파티션이 생성됩니다. 결국 6TB 크기의 파티션이 두 개 생성됩니다.

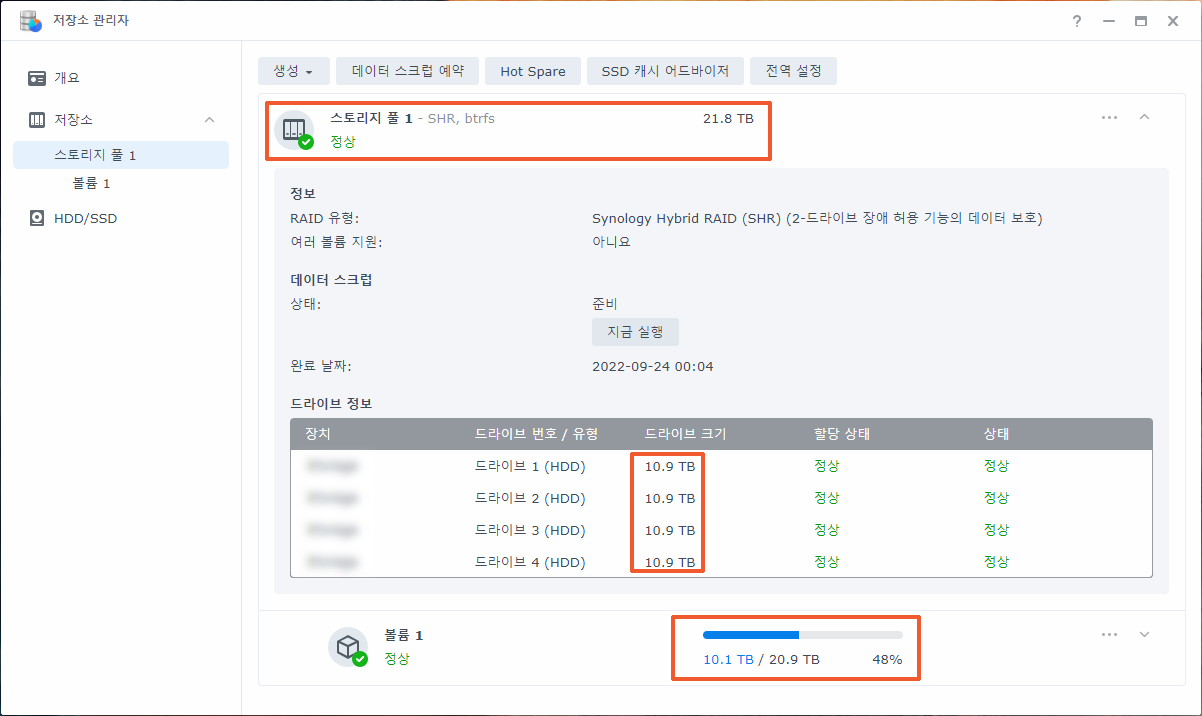

앞쪽의 6TB 파티션 4개는 raid6 방식의 12TB 공간(md2)이 되고, 뒤쪽의 6TB 파티션 4개도 raid6 방식의 12TB 공간(md3)이 됩니다. 두 개의 12TB 공간은 lvm을 사용해서 합쳐지고 최종적으로 24TB 크기의 공간(스토리지 풀)이 됩니다.

앞쪽의 6TB 파티션. recovery. 수리 중...

앞쪽의 6TB 파티션으로 만든 공간(md2)은 mdstat 파일에서 “recovery”로, 저장소 관리자에서 “수리”로 표기됩니다.

root@NAS:~# cat /proc/mdstat Personalities : [raid1] [raid6] [raid5] [raid4] [raidF1] md2 : active raid6 sdd5[4] sdc5[7] sdb5[6] sda5[5] 11711382912 blocks super 1.2 level 6, 64k chunk, algorithm 2 [4/3] [UUU_] [>....................] recovery = 0.0% (4242112/5855691456) finish=666.6min speed=146279K/sec md1 : active raid1 sdd2[3] sdc2[2] sdb2[1] sda2[0] 2097088 blocks [4/4] [UUUU] md0 : active raid1 sdd1[3] sdc1[2] sdb1[1] sda1[0] 2490176 blocks [4/4] [UUUU] unused devices: <none> root@NAS:~#

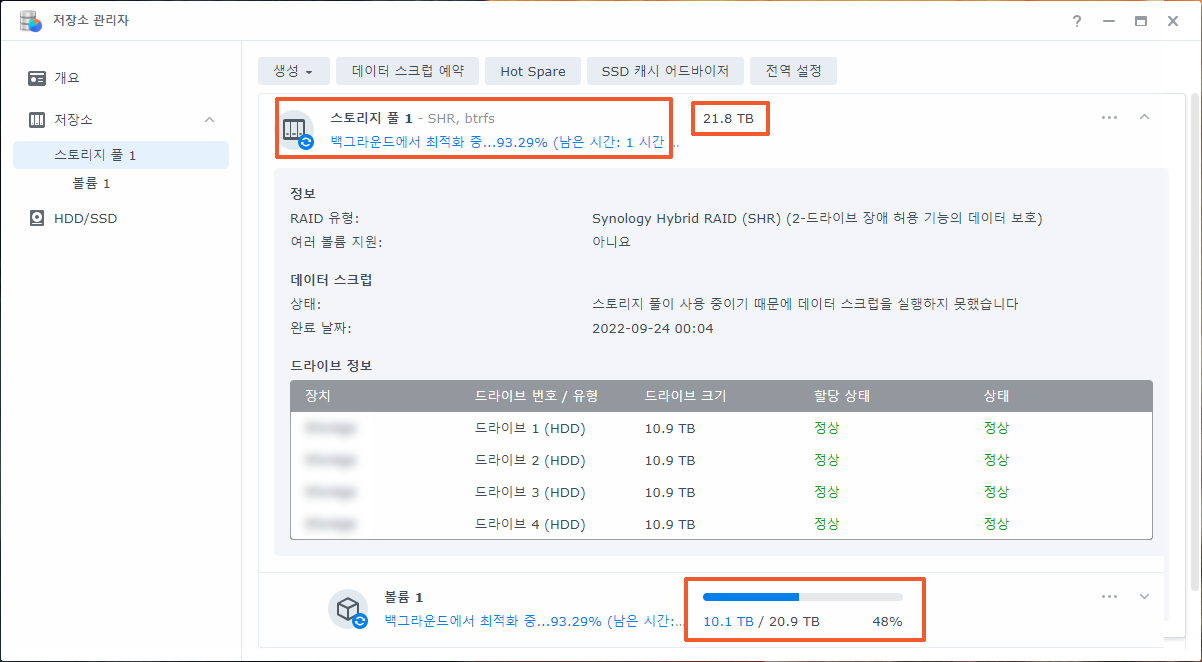

뒤쪽의 6TB 파티션. resync. 최적화 중...

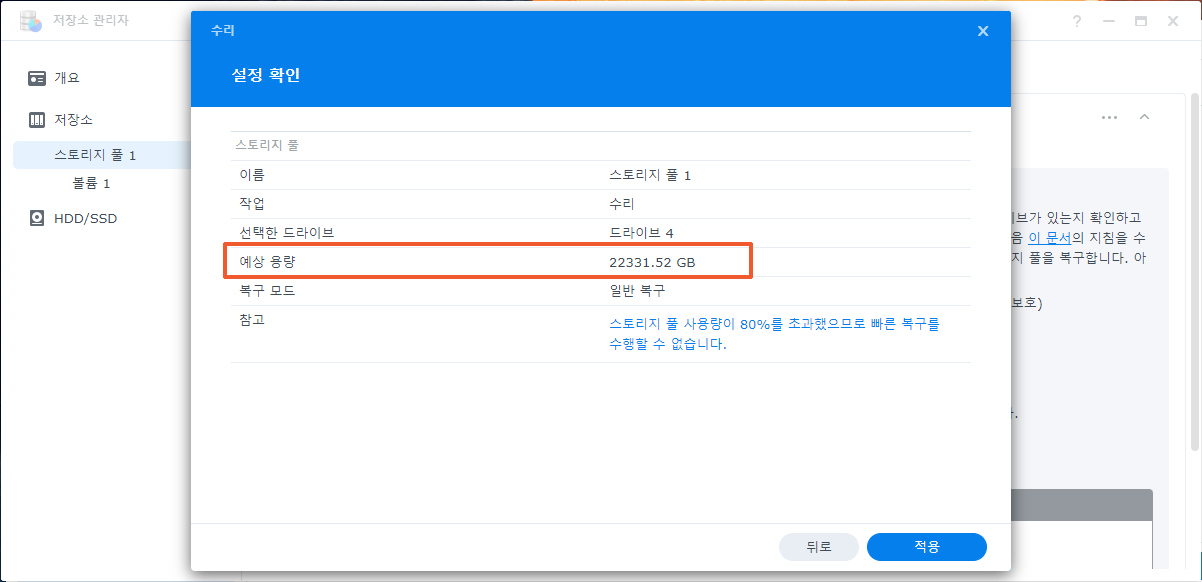

뒤쪽의 6TB 파티션으로 만든 공간(md3)은 mdstat 파일에서 “resync”로, 저장소 관리자에서 “최적화”로 표기됩니다. 최적화가 시작되면 곧바로 스토리지 풀의 크기와 볼륨의 크기가 확장됩니다.

root@NAS:~# cat /proc/mdstat Personalities : [raid1] [raid6] [raid5] [raid4] [raidF1] md3 : active raid6 sdd6[3] sdc6[2] sdb6[1] sda6[0] 11704908672 blocks super 1.2 level 6, 64k chunk, algorithm 2 [4/4] [UUUU] [==================>..] resync = 93.9% (5495792896/5852454336) finish=84.1min speed=70648K/sec md2 : active raid6 sdd5[4] sdc5[7] sdb5[6] sda5[5] 11711382912 blocks super 1.2 level 6, 64k chunk, algorithm 2 [4/4] [UUUU] md1 : active raid1 sdd2[3] sdc2[2] sdb2[1] sda2[0] 2097088 blocks [4/4] [UUUU] md0 : active raid1 sdd1[3] sdc1[2] sdb1[1] sda1[0] 2490176 blocks [4/4] [UUUU] unused devices: <none> root@NAS:~#

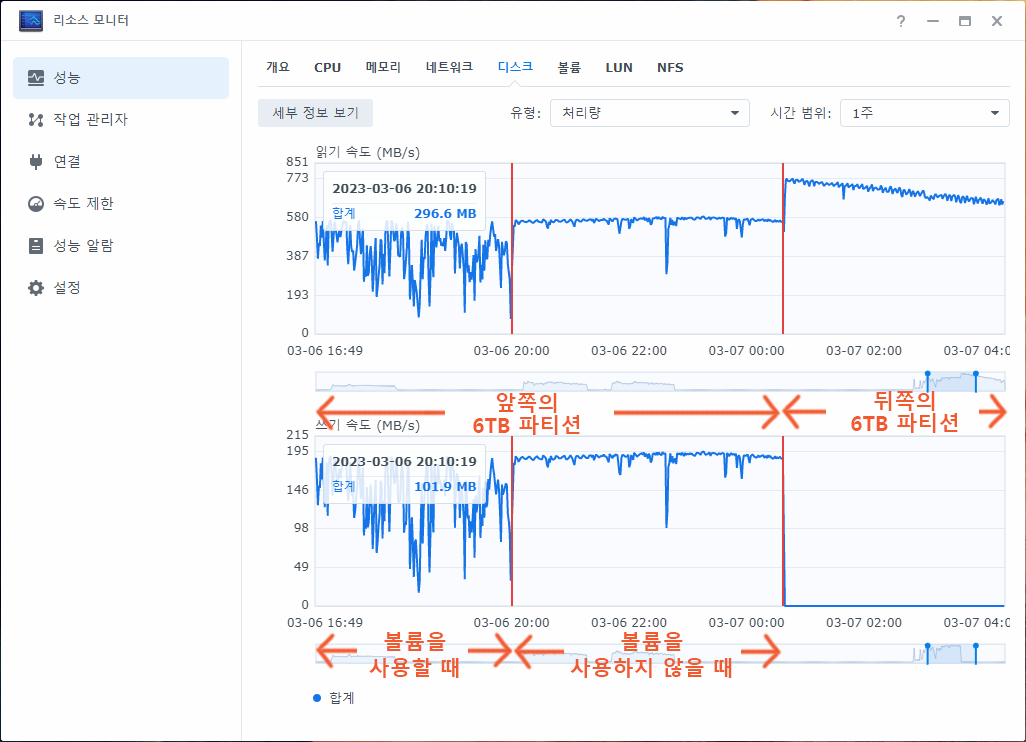

12TB 디스크의 처리량

앞쪽의 6TB 파티션으로 만든 공간(md2)에는 지금까지의 데이터가 들어 있습니다. 디스크를 교체하면 새 디스크에 그 데이터를 기록해야 하므로 읽기와 쓰기가 동시에 발생합니다. 만약 사용자가 데이터를 사용하면(볼륨을 사용하면) 디스크가 해야할 일이 늘어나므로 읽기, 쓰기 속도가 떨어집니다.

뒤쪽의 6TB 파티션으로 만든 공간(md3)에는 아무 데이터가 들어 있지 않습니다. 나스에 새 디스크를 장착하고 raid6 볼륨을 생성하는 경우와 마찬가지로 쓰기는 발생하지 않고 읽기만 발생합니다.

⑥ 2023/03/07 11:34:49 SYSTEM System successfully optimized [Storage Pool 1]. ⑤ 2023/03/07 00:47:53 userXXX System successfully repaired [Storage Pool 1] with drive [Drive 4]. ⑤ 2023/03/06 13:25:22 userXXX System started to repair [Storage Pool 1] with [Drive 4]. ⑤ 2023/03/06 13:18:04 SYSTEM Storage Pool [1] degraded [3/4 of drives remaining]. Please repair it. ⑤ 2023/03/06 13:18:03 userXXX Drive (SN:WD-WX11D29LXXXX) has been deactivated. ④ 2023/03/04 03:07:15 userXXX System successfully repaired [Storage Pool 1] with drive [Drive 3]. ④ 2023/03/03 11:48:00 userXXX System started to repair [Storage Pool 1] with [Drive 3]. ④ 2023/03/03 11:43:10 SYSTEM Storage Pool [1] degraded [3/4 of drives remaining]. Please repair it. ④ 2023/03/03 11:43:08 userXXX Drive (SN:WD-WX21D290XXXX) has been deactivated. ③ 2023/03/03 05:59:01 userXXX System successfully repaired [Storage Pool 1] with drive [Drive 2]. ③ 2023/03/02 14:26:12 userXXX System started to repair [Storage Pool 1] with [Drive 2]. ③ 2023/03/02 14:23:55 SYSTEM Storage Pool [1] degraded [3/4 of drives remaining]. Please repair it. ③ 2023/03/02 14:23:54 userXXX Drive (SN:WD-WX31D96RXXXX) has been deactivated. ② 2023/03/01 08:42:20 userXXX Update was complete. ① 2023/03/01 07:06:49 userXXX System successfully repaired [Storage Pool 1] with disk [드라이브 1]. ① 2023/02/28 15:27:46 SYSTEM System successfully checked consistency of System Volume [Root]. ① 2023/02/28 15:27:16 SYSTEM System successfully checked consistency of System Volume [Swap]. ① 2023/02/28 15:26:50 userXXX System starts to repair [Storage Pool 1] with disk [드라이브 1]. ① 2023/02/28 15:21:25 SYSTEM Storage Pool [1] was degrade [3/4], please repair it. ① 2023/02/28 15:21:23 userXXX Drive (SN:WD-WX31D96KXXXX) has been deactivated.

디스크를 교체하는 과정은 로그센터에 기록되어 있습니다. “repaired”는 앞쪽의 6TB 파티션을 수리한 기록이고, “optimized”는 뒤쪽의 6TB 파티션을 최적화한 기록입니다.