시놀로지 DS218의 볼륨 용량을 확장합니다.

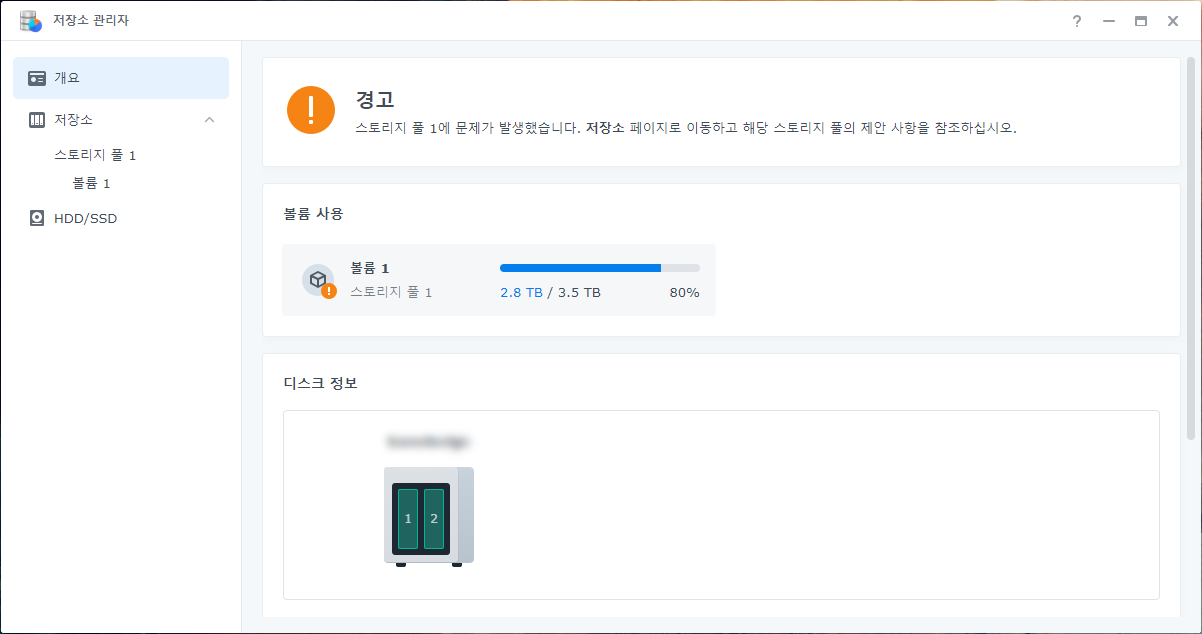

볼륨 사용량이 80%에 도달했습니다. 4TB 디스크 두 개를 SHR(raid1)로 사용하고 있습니다. 이 디스크를 10TB로 교체해서 볼륨의 용량을 확장하려고 합니다. 4TB 디스크의 용량을 80% 사용하기까지 4년 남짓 걸렸는데요. 데이터가 쌓이는 속도가 일정하다고 가정하면 10TB 디스크의 용량을 80% 사용하기까지 6년 이상 걸릴거라고 생각됩니다.

나스가 오작동을 일으키거나 성능이 부족하다고 느꼈다면 이번 기회에 나스도 같이 교체하기를 권장하는데요. 나스에는 아쉬운 점이 없습니다. 그래서 우선은 디스크만 교체하고 나스는 조금 더 사용하기로 합니다. 시놀로지는 마이그레이션 기능을 제공합니다. 나중에 나스를 교체할 일이 생겨도 마이그레이션 기능을 사용하면 10TB 디스크는 계속 사용하면서 나스만 교체하는 작업을 손쉽게 할 수 있습니다.

소요시간 : 2일 어려움 : ★★★★★

디스크를 한 개씩 교체합니다.

디스크를 교체할 때는 상태가 좋지 않은 디스크를 먼저 교체하는게 좋습니다. 상태가 좋지 않다는 말은 사용한 시간이 더 많고, 배드섹터가 발생한 이력이 있고, 배드섹터가 여전히 남아있고, SMART 정보에 특이점이 있어서 오작동이 발생할 확률이 더 높아보이는 것을 의미합니다. 이번 사례에서는 드라이브 1의 상태가 좋지 않아서 드라이브 1을 먼저 교체합니다. 상태가 좋지 않은 디스크를 나중에 교체할 경우 교체하는 작업이 중단되기도 합니다. 따라서 디스크의 상태를 잘 판단하고 교체하는 순서 또한 잘 결정해야 합니다.

4TB 디스크의 데이터를 10TB 디스크로 모두 복제하려면 최소한 7시간 정도 소요됩니다. 그래서 하루에 한 개밖에 교체하지 못하며, 총 이틀이 소요됩니다. raid1을 사용하고 있으므로 디스크를 교체하는 동안에도 나스를 계속 사용할 수 있습니다.

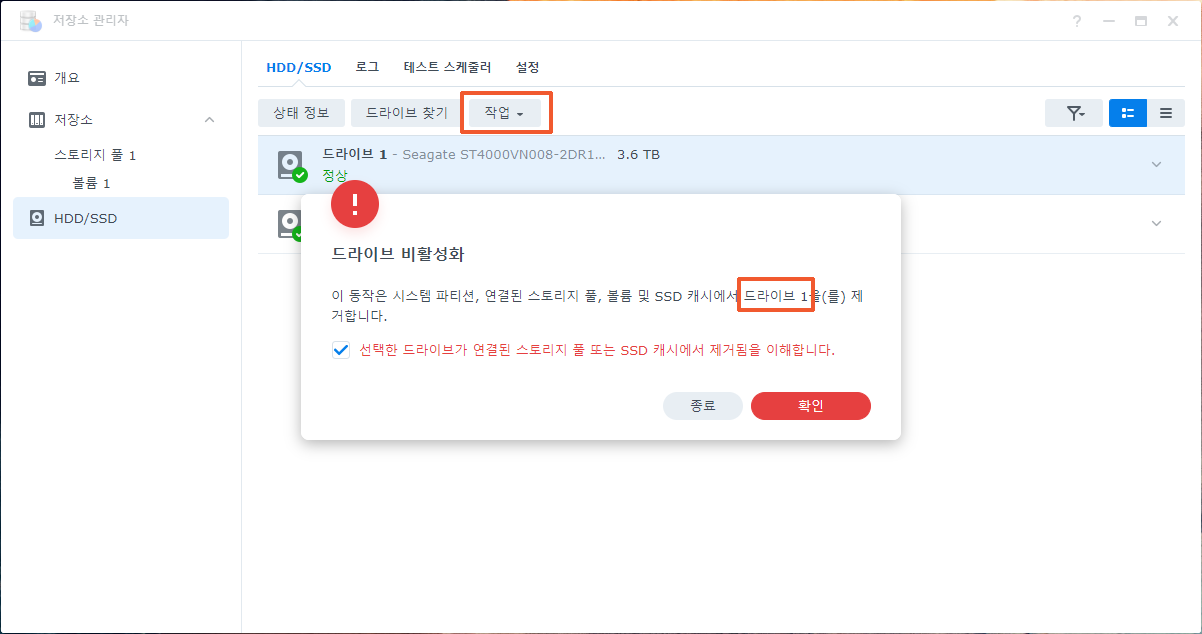

- 드라이브 1(4TB 디스크)을 비활성화 합니다.

- 드라이브 1(4TB 디스크)을 나스에서 제거하고 10TB 디스크를 장착합니다.

- 수리를 클릭합니다.

- 수리가 완료되면 드라이브 2도 똑같은 방법으로 교체합니다.

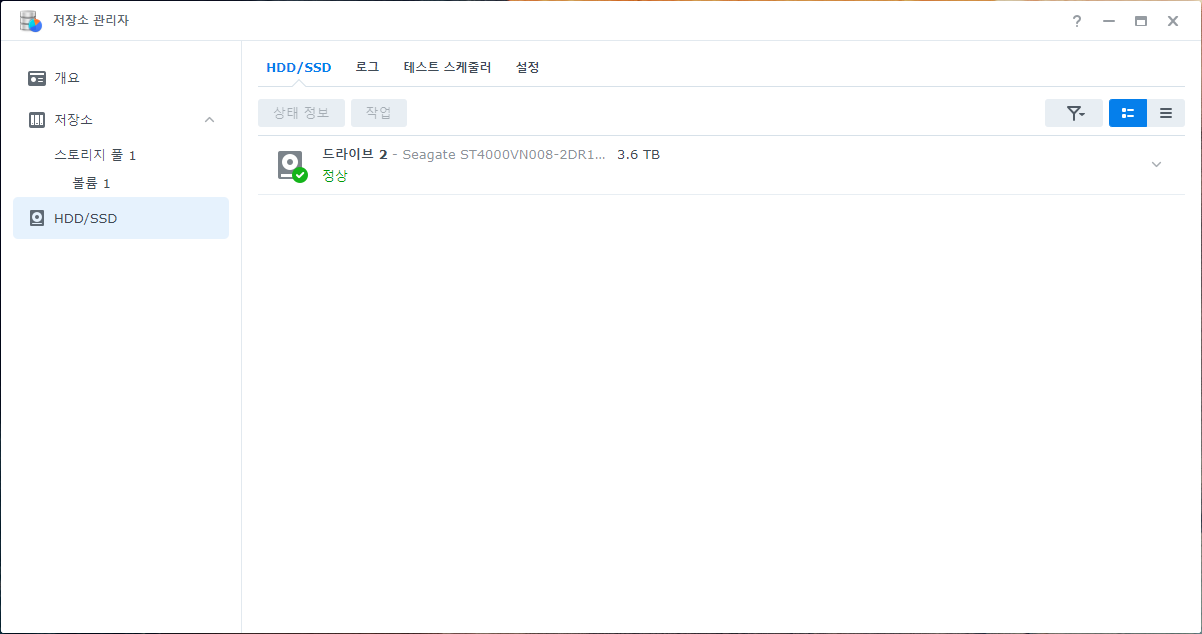

비활성화를 한 뒤에는 디스크를 나스에서 제거합니다. 제거후에는 드라이브 1이 목록에서 사라집니다.

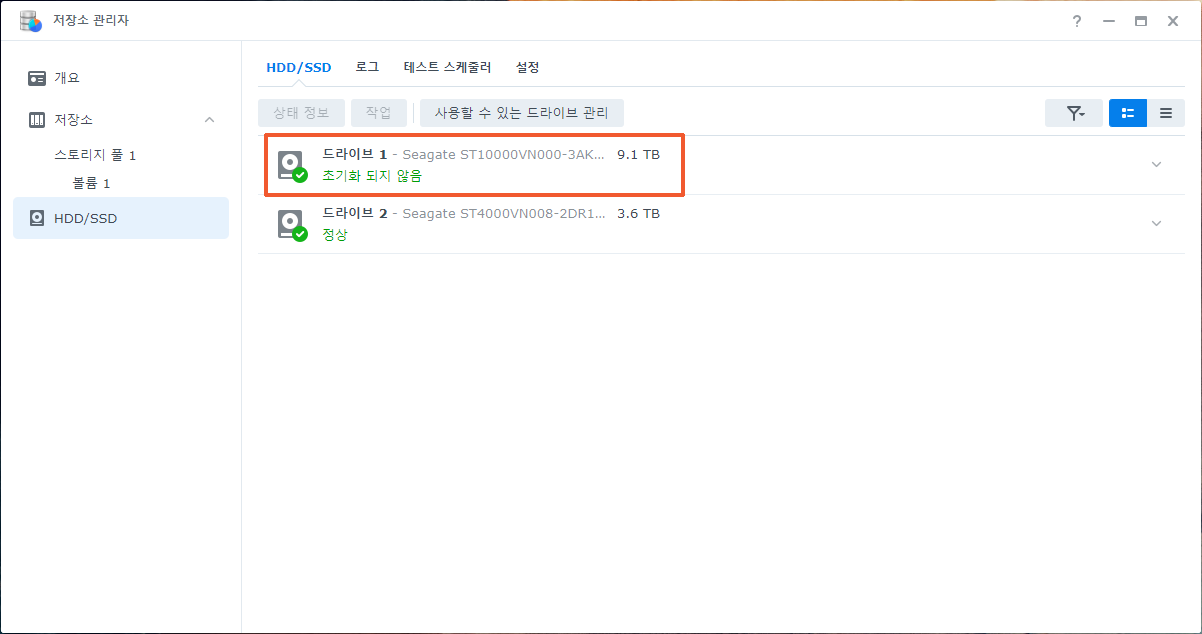

4TB 디스크를 제거한 곳에 10TB 디스크를 장착합니다. 장착하고 1분 정도 기다리면 드라이브 1이 나타납니다.

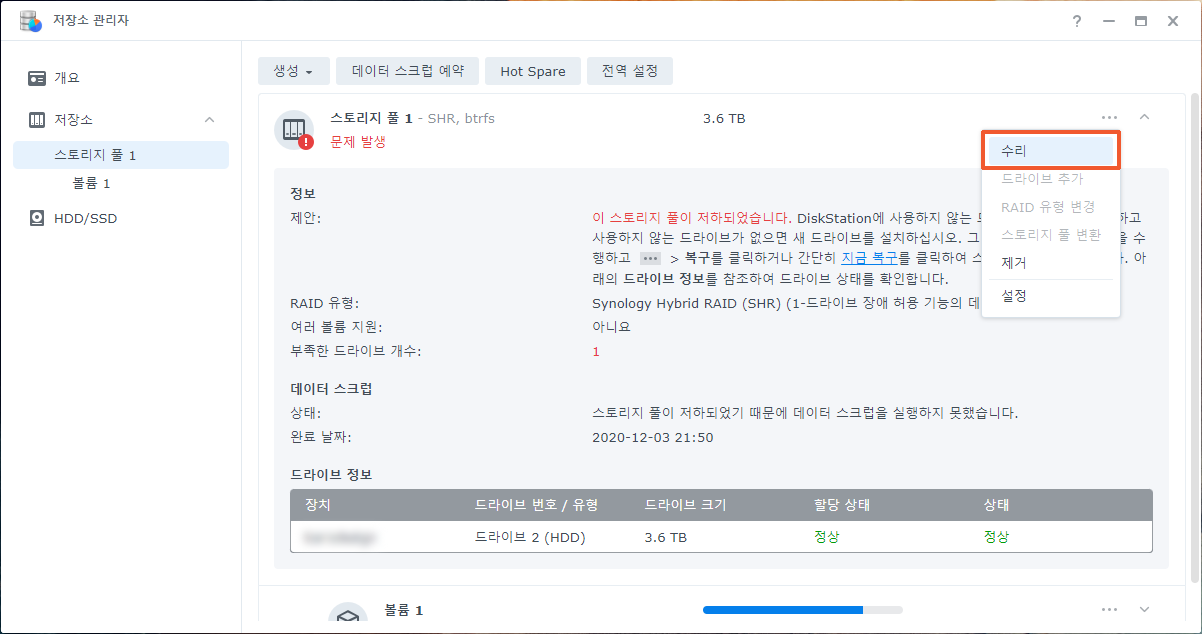

스토리지 풀 1을 관리하는 메뉴(… 아이콘)를 클릭하고 수리를 클릭합니다.

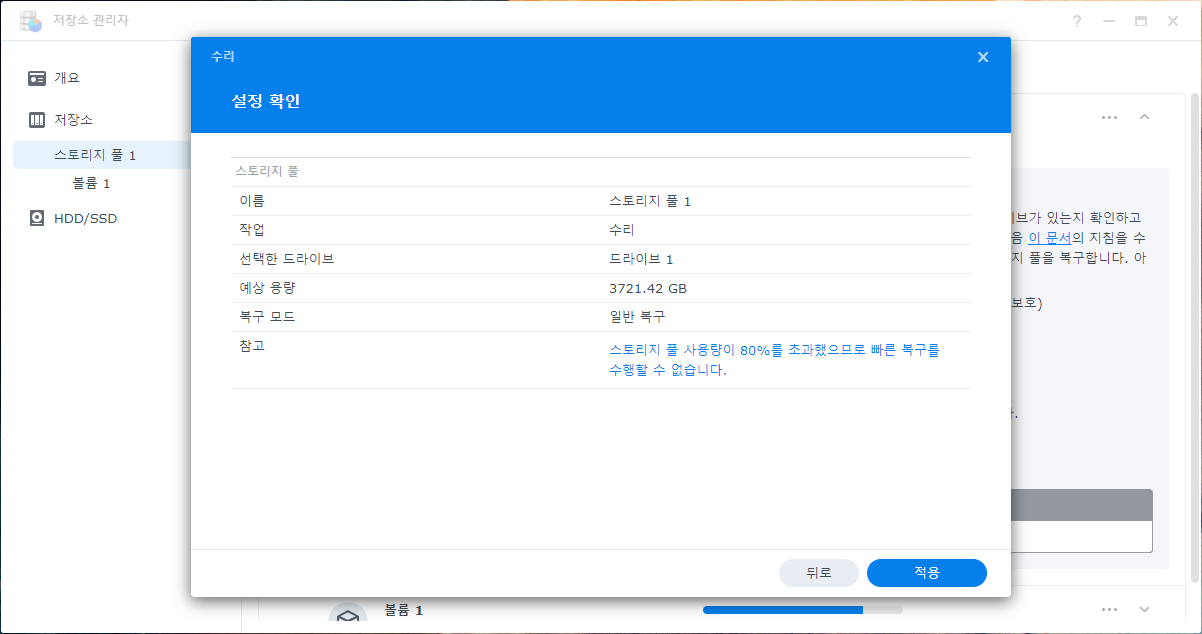

내용을 한 번 읽어보고 적용 버튼을 클릭합니다.

4TB 디스크를 일반 복구로 진행할 경우에 최소한 7시간이 소요됩니다. 디스크의 속도가 느리거나 나스를 많이 사용(파일 저장 또는 파일 열기)하면 시간이 더 소요됩니다.

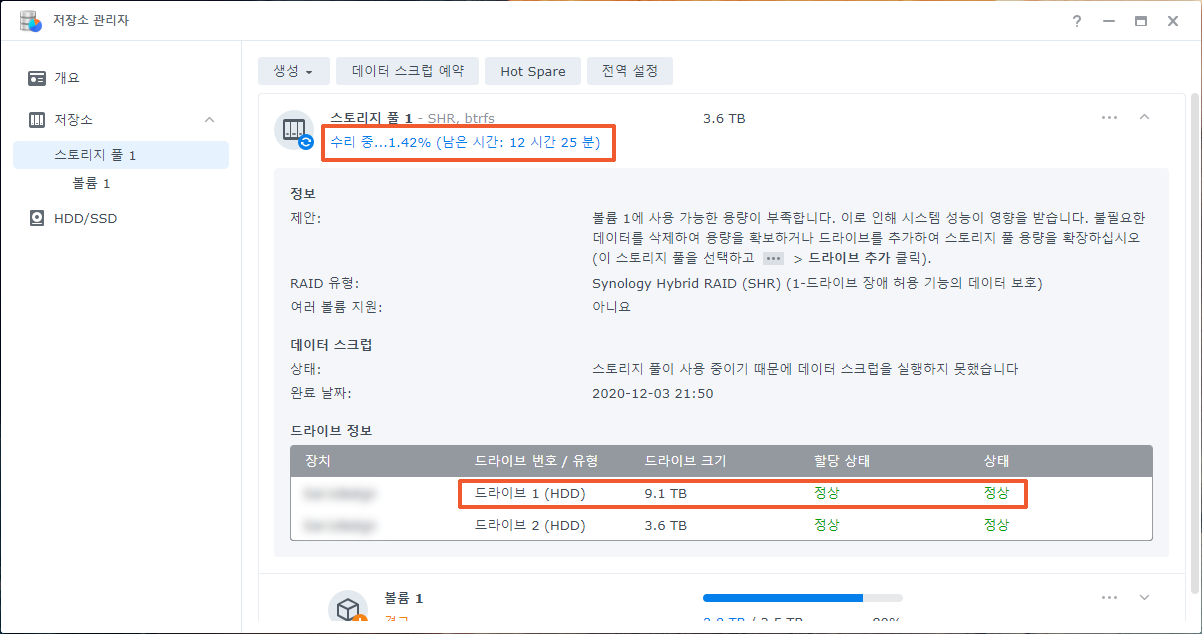

드라이브 1을 교체하는 과정이 끝났습니다. 수리가 완료되면 수리중…x%(남은 시간:x시간 x분) 글자가 사라집니다.

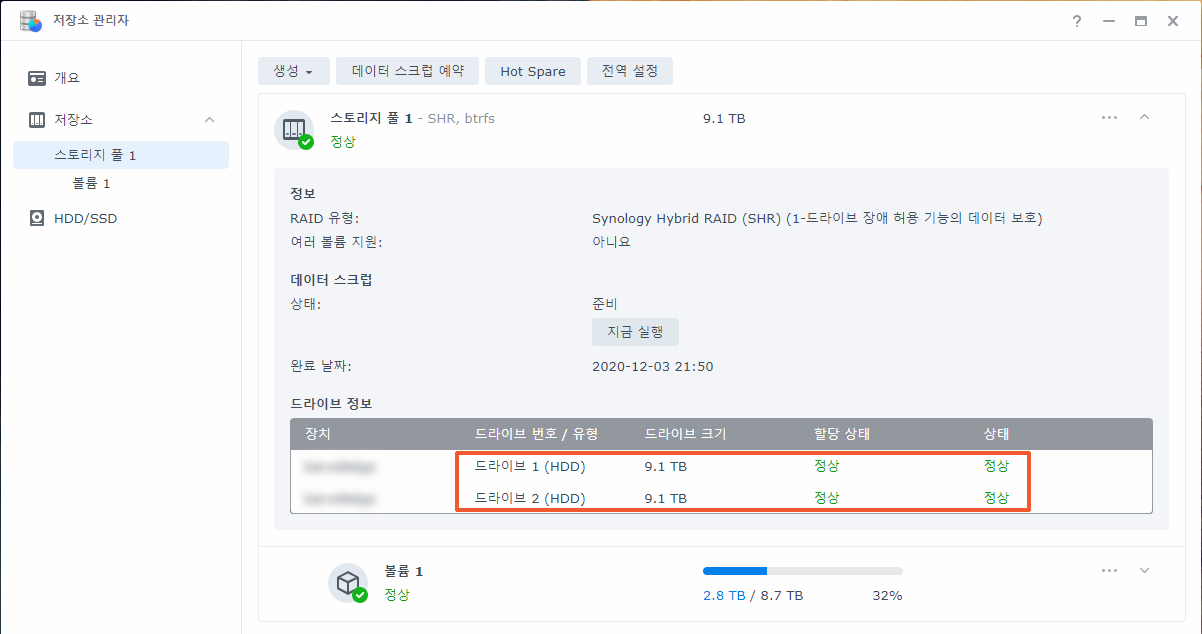

드라이브 2도 교체합니다. 드라이브 1을 교체하는 방법과 똑같이 진행하면 됩니다. 드라이브 2의 수리가 완료되면 볼륨의 용량이 늘어납니다.

드라이브 1을 수리하는데 걸린 시간은 11시간 20분, 드라이브 2를 수리하는데 걸린 시간은 7시간입니다.

4TB 디스크는 볼륨의 크기가 3.5TB, 10TB 디스크는 볼륨의 크기가 8.7TB입니다.

궁금하면 ↓↓↓↓

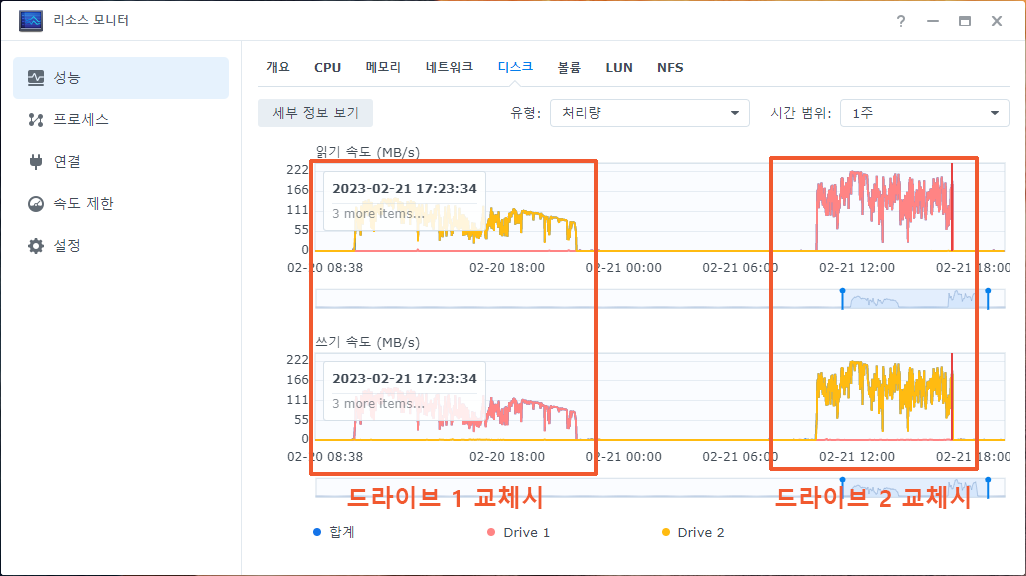

드라이브 1을 교체하면 드라이브 2에서 내용을 읽어서 드라이브 1에 기록합니다. 따라서 읽기 속도 그래프는 드라이브 2를 의미하는 노란색이고, 쓰기 속도 그래프는 드라이브 1을 의미하는 빨간색이 됩니다. 드라이브 2를 교체하는 경우에는 반대가 됩니다.

드라이브 2를 교체할 때는 속도가 더 빠른 것을 볼 수 있습니다. 그 이유는 10TB 디스크의 앞 부분 4TB 까지만 복제하기 때문입니다. 하드디스크는 앞 부분의 속도가 가장 빠르고 뒷 부분으로 갈수록 속도가 느려집니다.

4TB + 6TB = 10TB

SHR(raid1)을 사용하는 경우에는 10TB 디스크로 모두 교체한 뒤에도 여전히 4TB 크기의 공간을 가지고 있습니다. 10TB 디스크를 4TB 크기의 공간과 6TB 크기의 공간으로 나눈 뒤 다시 이 둘을 합쳐서 10TB 크기의 용량으로 사용합니다. 이렇게 하는 이유는 SHR이 제공하는 장점 중에서 디스크의 용량을 최대로 사용하는 기능 때문입니다. 일반적인 raid1을 사용하는 경우에는 10TB 크기의 공간을 하나만 만들어서 10TB 용량을 사용합니다.

root@nas:~# parted /dev/sda print free

Model: ATA ST10000VN000-3AK (scsi)

Disk /dev/sda: 10.0TB

Sector size (logical/physical): 512B/512B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

17.4kB 4194kB 4177kB Free Space

1 4194kB 8594MB 8590MB ext4 raid

2 8594MB 10.7GB 2147MB linux-swap(v1) raid

10.7GB 10.9GB 142MB Free Space

5 10.9GB 4007GB 3996GB raid

4007GB 10.0TB 5994GB Free Space

root@nas:~# cat /proc/mdstat

Personalities : [raid1]

md2 : active raid1 sda5[2] sdb5[1]

3902187456 blocks super 1.2 [2/2] [UU]

md1 : active raid1 sda2[0] sdb2[1]

2097088 blocks [2/2] [UU]

md0 : active raid1 sda1[0] sdb1[1]

2490176 blocks [2/2] [UU]

unused devices: <none> 10TB 디스크를 한 개만 교체한 상태에서는 4TB 크기의 공간을 만들고, 나머지 6TB 공간은 사용하지 않고 그대로(Free Space) 놔둡니다.

root@nas:~# parted /dev/sda print free

Model: ATA ST10000VN000-3AK (scsi)

Disk /dev/sda: 10.0TB

Sector size (logical/physical): 512B/512B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

17.4kB 4194kB 4177kB Free Space

1 4194kB 8594MB 8590MB ext4 raid

2 8594MB 10.7GB 2147MB linux-swap(v1) raid

10.7GB 10.9GB 142MB Free Space

5 10.9GB 4007GB 3996GB raid

4007GB 4007GB 8241kB Free Space

6 4007GB 10.0TB 5994GB raid

10.0TB 10.0TB 98.0MB Free Space

root@nas:~# parted /dev/sdb print free

Model: ATA ST10000VN000-3AK (scsi)

Disk /dev/sdb: 10.0TB

Sector size (logical/physical): 512B/512B

Partition Table: gpt

Disk Flags:

Number Start End Size File system Name Flags

17.4kB 4194kB 4177kB Free Space

1 4194kB 8594MB 8590MB ext4 raid

2 8594MB 10.7GB 2147MB linux-swap(v1) raid

10.7GB 10.9GB 142MB Free Space

5 10.9GB 4007GB 3996GB raid

4007GB 4007GB 8241kB Free Space

6 4007GB 10.0TB 5994GB raid

10.0TB 10.0TB 98.0MB Free Space

root@nas:~# cat /proc/mdstat

Personalities : [raid1]

md2 : active raid1 sdb5[3] sda5[2]

3902187456 blocks super 1.2 [2/1] [U_]

[>....................] recovery = 0.1% (5483904/3902187456) finish=518.8min speed=125175K/sec

md1 : active raid1 sdb2[1] sda2[0]

2097088 blocks [2/2] [UU]

md0 : active raid1 sdb1[1] sda1[0]

2490176 blocks [2/2] [UU]

unused devices: <none>

root@nas:~# lvm pvdisplay

--- Physical volume ---

PV Name /dev/md2

VG Name vg1000

PV Size 3.63 TiB / not usable 1.94 MiB

Allocatable yes (but full)

PE Size 4.00 MiB

Total PE 952682

Free PE 0

Allocated PE 952682

PV UUID Xi3Ikc-t0u5-dmvw-UTOd-C2qW-zQZG-kPfiCK

root@nas:~# 10TB 디스크를 두 개 모두 교체하면 6TB 부분을 새로운 공간으로 만듭니다. 하지만 4TB 공간의 수리가 완료되기 전까지는 6TB 공간을 사용하지 않습니다.

root@nas:~# cat /proc/mdstat Personalities : [raid1] md3 : active raid1 sdb6[1] sda6[0] 5853514624 blocks super 1.2 [2/2] [UU] md2 : active raid1 sdb5[3] sda5[2] 3902187456 blocks super 1.2 [2/2] [UU] md1 : active raid1 sdb2[1] sda2[0] 2097088 blocks [2/2] [UU] md0 : active raid1 sdb1[1] sda1[0] 2490176 blocks [2/2] [UU] unused devices: <none> root@nas:~# lvm pvdisplay --- Physical volume --- PV Name /dev/md2 VG Name vg1000 PV Size 3.63 TiB / not usable 1.94 MiB Allocatable yes (but full) PE Size 4.00 MiB Total PE 952682 Free PE 0 Allocated PE 952682 PV UUID Xi3Ikc-t0u5-dmvw-UTOd-C2qW-zQZG-kPfiCK --- Physical volume --- PV Name /dev/md3 VG Name vg1000 PV Size 5.45 TiB / not usable 2.88 MiB Allocatable yes (but full) PE Size 4.00 MiB Total PE 1429080 Free PE 0 Allocated PE 1429080 PV UUID VFiJ4k-hAfI-jyXa-Lt36-P6Ek-NEZW-31ye4Z root@nas:~#

4TB 공간의 수리가 완료되면 비로소 6TB 공간을 사용합니다. md3을 생성하고 md2와 합쳐서 10TB 전체를 볼륨으로 사용합니다. SHR이 아닌 일반적인 raid1일 경우에는 md3을 생성하지 않고 md2의 사이즈를 확장해서 10TB 전체를 사용합니다.

2023/02/21 17:25:34 admin System successfully repaired [Storage Pool 1] with drive [Drive 2]. 2023/02/21 10:26:09 admin System started to repair [Storage Pool 1] with [Drive 2]. 2023/02/21 10:23:53 SYSTEM Storage Pool [1] degraded [1/2 of drives remaining]. Please repair it. 2023/02/21 10:23:49 admin Drive (SN:ZGY1XXXX) has been deactivated. 2023/02/20 22:03:56 admin System successfully repaired [Storage Pool 1] with drive [Drive 1]. 2023/02/20 10:42:10 admin System started to repair [Storage Pool 1] with [Drive 1]. 2023/02/20 10:38:47 SYSTEM Storage Pool [1] degraded [1/2 of drives remaining]. Please repair it. 2023/02/20 10:38:42 admin Drive (SN:ZDH3XXXX) has been deactivated.

디스크를 교체하는 과정은 로그 센터에도 기록됩니다. 드라이브 1 수리에 소요된 시간은 11시간 20분, 드라이브 2 수리에 소요된 시간은 7시간입니다.

디스크 교체 중에(수리중인 상태에서)서,

나스 서버에 접속 / 파일 읽기 / 파일 저장 등의 작업이 가능한가요?

네 가능합니다. 평상시와 똑같이 나스에 저장한 파일을 사용할 수 있습니다.

하지만 속도는 조금 느릴수 있어요.

4TB + 6TB = 10TB 라는 문장부터의 진행과정은

사용자가 직접 하는게 아니고 SHR 사용중 디스크 교체시 자동으로 진행되는건가요?

현재 ds416j에 3TB *4 = 12TB 용량이 거의 다 차서, 16TB *2 혹은 8TB *4로 변경 예정입니다.

4TB + 6TB = 10TB 라는 문장부터의 진행과정은 자동으로 진행됩니다.

이부분은 디스크를 교체하는 경우에 내부에서 어떤 일이 일어나는지를 설명한 것입니다.

3TB * 4, SHR이면 3X3=9TB 용량을 사용할 수 있습니다.

3TB중에서 아무거나 두 개를 16TB로 교체하면 9+13=22TB로 늘어납니다.

3TB 모두 8TB로 교체하면 8×3=24TB로 늘어납니다.

답변 감사드립니다.

저번에 제가 잘못 말씀드렸는데 현재 4TB*4 = 약 10.9TB를 SHR로 사용 중에 있습니다.

ds416j 동일한 기종의 나스를 2개 사용중이며, 사용기간은 나스와 하드 모두 약 5년 7개월 정도입니다.

한 개는 메인, 나머지 한 개는 백업(매일 새벽시간대 동기화)으로 사용중입니다.

현재 사용가능한 용량이 1TB 남짓 남아 나스와 하드 모두 교체하려던 참에 jacjac님이 올리신 글들을 보고 하드만 교체 예정인데

1. 사용기간, 안정성을 고려하여 나스도 함께 교체하는 것이 좋을까요?

2. 만약 나스도 교체한다면 백업 나스가 있으니 메인과 백업 둘 다 레이드 구성없이 하드 볼륨 용량 전체를 사용하는 건 리스크가 너무 클까요?

1.나스도 함께 교체하는 것이 좋을까요?

네. 5년7개월을 사용했으면 나스와 하드를 모두 교체하기를 권장합니다.

2. 레이드 없이 하드 용량 전체를 사용하는 건 어떤가요?

나스 유지관리를 쉽게 하려면 레이드1이나 레이드5 사용을 권장합니다.

선택이 어려우시면 디스크가 고장나서 메인나스가 정상적인 기능을 하지 못할 경우, 그로 인한 손해와 디스크 가격을 따져서 결정하세요.

디스크 고장으로 인한 손해는 업무중단으로 인한 시간적인 손실과 나스를 정상화시키는데 드는 비용과 노동이 있습니다.

디스크 1개 가격은 수십만 원 합니다.

레이드1이나 레이드5는 수십만 원짜리 보험이라고 보시면 됩니다. 보험의 기능은 디스크 고장으로 인한 손해를 1회 막아주고요. 손해의 규모는 나스를 사용하는 곳마다 다 다르므로 직접 판단하셔서 결정하시면 됩니다.

용량 확장은 DISK2 수리 완료 후 자동으로 확장 된다는 말씀이신가요?

네. 나중에 교체한 디스크의 수리가 완료되면 용량이 늘어납니다.

저상태에서 수리를 진행하게되면 다른 스토리지 폴의 데이터가 있다고 나오지않나요? 이 때 무시하고 진행해도 되는것이 맞는건가요?

수리에 사용하는 디스크는 새로운 내용을 기록하므로 디스크에 저장된 내용이 지워집니다.

만약 이미 시놀로지 나스에서 사용하던 디스크를 수리에 사용하는 경우에는 스토리지 풀로 사용하던 디스크라는 것을 알아차리고 “다른 스토리지 풀의 데이터가 들어있다”고 나옵니다.

내용이 지워져도 되는 디스크라면 경고메시지를 수락하고 계속 진행하시면 됩니다.