DSM에 접속이 안됩니다.

나스에서 여러 가지 문제가 다양하게 발생합니다. DSM에 로그인이 되지 않습니다. WebDAV을 포함해서 각종 패키지가 정상적으로 작동하지 않습니다. 로그 센터가 열리지 않습니다. 저장소 관리자에서 드라이브 “상태 정보” 화면이 열리지 않습니다.

이런 증상이 발생한 원인은 시스템 공간이 가득 찼기 때문입니다. 나스의 운영체제는 시스템 공간에 수시로 임시 파일을 생성하고 지우기를 반복하는데요. 빈 공간이 없어서 임시 파일을 생성하지 못하면 위와 같은 여러 가지 오류가 발생합니다. 시스템 공간이 가득 찬 이유는 Active Insight에서 파일 활동(File Activity)을 저장하는 데이터베이스 파일이 시스템 공간의 남은 공간을 모두 사용했기 때문입니다. 최신 버전의 Active Insight는 데이터베이스 파일을 볼륨에 저장하므로 이런 문제를 일으키지 않습니다.

Active Insight는 나스의 상태, 성능, 보안을 모니터링하는 툴입니다.

소요시간 : 30분 어려움 : ★★★★★

시스템 공간에 빈 공간을 확보합니다.

du 명령어를 사용해서 많은 용량을 잡아먹고 있는 파일을 찾아냅니다. 이번 사례에서는 /usr/local/packages/@appdata/ActiveInsight/lfs/file_activity/statistic.sqlite 파일이 시스템 공간을 35% 정도 차지하고 있습니다. 이 파일을 삭제하거나 이동해서 시스템 공간에 빈 공간을 만들어 줍니다.

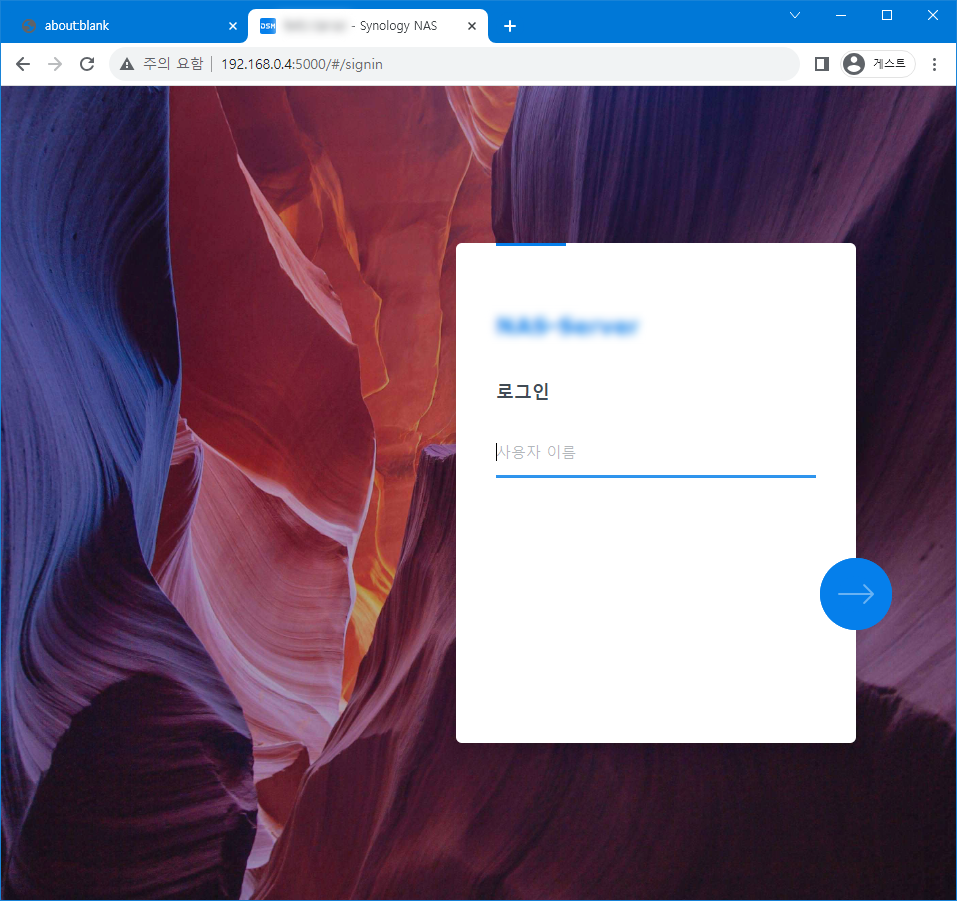

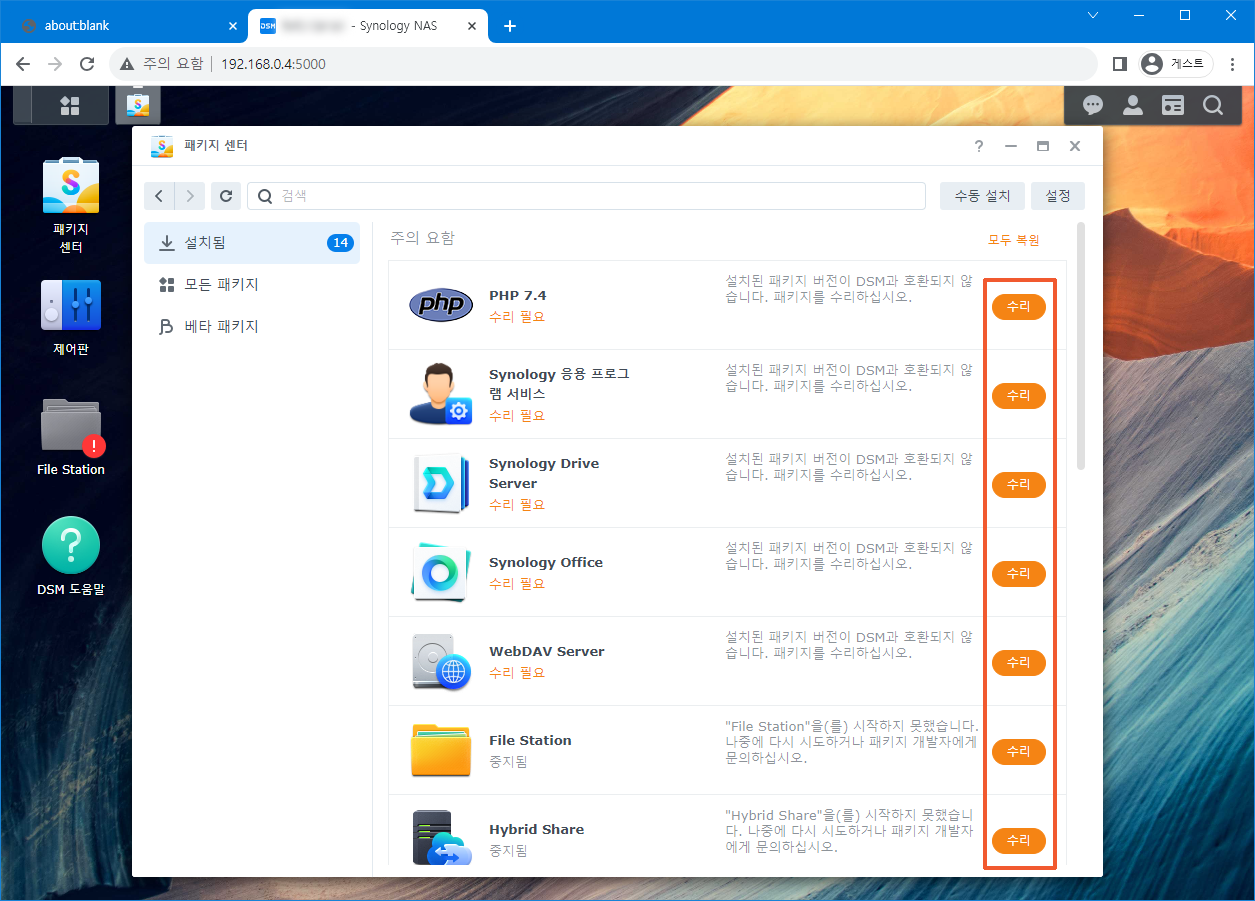

빈 공간을 확보했으면 나스를 다시 시작합니다. 나스를 다시 시작하면 이제는 DSM에 로그인이 됩니다. 로그인해서 수리가 필요한 패키지가 남아 있으면 수리를 진행합니다.

많은 용량을 차지하는 파일을 찾는 과정

root@NAS:/var/log# df -h Filesystem Size Used Avail Use% Mounted on /dev/md0 2.3G 2.3G 0 100% / devtmpfs 2.8G 0 2.8G 0% /dev tmpfs 2.9G 180K 2.9G 1% /dev/shm tmpfs 2.9G 18M 2.9G 1% /run tmpfs 2.9G 0 2.9G 0% /sys/fs/cgroup tmpfs 2.9G 612K 2.9G 1% /tmp /dev/vg1/volume_1 3.5T 439G 3.1T 13% /volume1 /dev/vg2/volume_2 7.0T 6.5T 539G 93% /volume2 root@NAS:/var/log# du -h -d 1 --exclude=/volume[12] / 80K /root 161M /var 3.9M /etc 4.0K /lost+found 4.0K /initrd du: cannot access '/proc/22579/task/22579/fd/3': No such file or directory du: cannot access '/proc/22579/task/22579/fdinfo/3': No such file or directory du: cannot access '/proc/22579/fd/4': No such file or directory du: cannot access '/proc/22579/fdinfo/4': No such file or directory 0 /proc 2.1M /.log.junior 9.3M /var.defaults 14M /run 20K /.system_info 4.0K /config 332K /tmp 24K /.old_patch_info 180K /dev 2.1G /usr 2.5M /etc.defaults 4.0K /mnt 41M /.syno 0 /sys 2.3G / root@NAS:/var/log# du -h -d 1 /usr 26M /usr/sbin 32K /usr/libexec 20K /usr/etc 118M /usr/bin 16M /usr/lib32 1.3G /usr/local 360M /usr/lib 245M /usr/syno 76K /usr/include 88M /usr/share 2.1G /usr root@NAS:/var/log# du -h -d 1 /usr/local 20K /usr/local/libexec 432K /usr/local/etc 252K /usr/local/bin 34M /usr/local/lib 20K /usr/local/node 1020K /usr/local/plugin 1.2G /usr/local/packages 7.8M /usr/local/share 1.3G /usr/local root@NAS:/var/log# du -h -d 1 /usr/local/packages/ 877M /usr/local/packages/@appdata 60K /usr/local/packages/@appshare 8.0K /usr/local/packages/@tmp 19M /usr/local/packages/@apptemp 299M /usr/local/packages/@appstore 64K /usr/local/packages/@apphome 1.2G /usr/local/packages/ root@NAS:/var/log# du -h -d 1 /usr/local/packages/@appdata 180K /usr/local/packages/@appdata/SupportService 877M /usr/local/packages/@appdata/ActiveInsight 4.0K /usr/local/packages/@appdata/StorageManager 52K /usr/local/packages/@appdata/SMBService 4.0K /usr/local/packages/@appdata/SynoFinder 4.0K /usr/local/packages/@appdata/SynoOnlinePack_v2 4.0K /usr/local/packages/@appdata/FileStation 4.0K /usr/local/packages/@appdata/USBCopy 4.0K /usr/local/packages/@appdata/HybridShare 4.0K /usr/local/packages/@appdata/SecureSignIn 4.0K /usr/local/packages/@appdata/ScsiTarget 4.0K /usr/local/packages/@appdata/dsm6-ui-compatible 4.0K /usr/local/packages/@appdata/QuickConnect 4.0K /usr/local/packages/@appdata/Python2 4.0K /usr/local/packages/@appdata/OAuthService 877M /usr/local/packages/@appdata root@NAS:/var/log# du -h -d 1 /usr/local/packages/@appdata/ActiveInsight 8.0K /usr/local/packages/@appdata/ActiveInsight/synomibanalyze 488K /usr/local/packages/@appdata/ActiveInsight/collectors 876M /usr/local/packages/@appdata/ActiveInsight/lfs 20K /usr/local/packages/@appdata/ActiveInsight/zzz 20K /usr/local/packages/@appdata/ActiveInsight/event 877M /usr/local/packages/@appdata/ActiveInsight root@NAS:/var/log# cd /usr/local/packages/@appdata/ActiveInsight root@NAS:/usr/local/packages/@appdata/ActiveInsight# ls -al total 36 drwxr-xr-x 7 root root 4096 Nov 13 17:54 . drwxr-xr-x 17 root root 4096 Oct 26 12:02 .. drwxr-xr-x 4 root root 4096 Oct 26 12:00 collectors -rw-r--r-- 1 root root 3095 Oct 26 12:00 collectors.conf drwx------ 3 root root 4096 Oct 26 11:59 event drwxr-xr-x 3 root root 4096 Oct 26 12:00 lfs -rw-r--r-- 1 root root 26 Nov 13 17:49 pkg_status.json drwxr-xr-x 3 root root 4096 Oct 26 11:59 synomibanalyze drwx------ 5 root root 4096 Nov 13 15:05 zzz root@NAS:/usr/local/packages/@appdata/ActiveInsight# cd lfs/ root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs# ls -al total 12 drwxr-xr-x 3 root root 4096 Oct 26 12:00 . drwxr-xr-x 7 root root 4096 Nov 13 17:54 .. drwxr-xr-x 2 root root 4096 Nov 13 13:43 file_activity root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs# cd file_activity/ root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# ls -alh total 876M drwxr-xr-x 2 root root 4.0K Nov 13 13:43 . drwxr-xr-x 3 root root 4.0K Oct 26 12:00 .. -rw-r--r-- 1 root root 876M Nov 10 16:29 statistic.sqlite root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity#

du 명령어를 반복하다 보면 큰 용량의 파일이 발견됩니다. 876MB 크기의 statistic.sqlite 파일을 찾았습니다.

파일 이동하기

root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# mv ./statistic.sqlite /volume1 root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# df -h Filesystem Size Used Avail Use% Mounted on /dev/md0 2.3G 1.5G 775M 65% / devtmpfs 2.8G 0 2.8G 0% /dev tmpfs 2.9G 180K 2.9G 1% /dev/shm tmpfs 2.9G 14M 2.9G 1% /run tmpfs 2.9G 0 2.9G 0% /sys/fs/cgroup tmpfs 2.9G 608K 2.9G 1% /tmp /dev/vg1/volume_1 3.5T 439G 3.1T 13% /volume1 /dev/vg2/volume_2 7.0T 6.5T 539G 93% /volume2 root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity#

mv 명령어를 사용해서 시스템 공간이 아닌 곳으로 파일을 이동합니다. 저는 volume1로 이동했습니다. 파일을 곧바로 삭제하기보다는 우선은 이동하기를 권장합니다. 이동한 이후에 파일이 필요하지 않다고 확신이 들면 그 때 삭제하면 됩니다. 파일을 이동하고 나니 사용률이 100%에서 65%로 떨어졌습니다. 이제 나스를 다시 시작하면 됩니다.

로그인해서 패키지 수리하기

나스를 다시 시작하면 이제는 DSM에 접속이 됩니다.

수리가 필요한 패키지를 수리합니다.

궁금하면 ↓↓↓↓

statistic.sqlite 파일의 용도

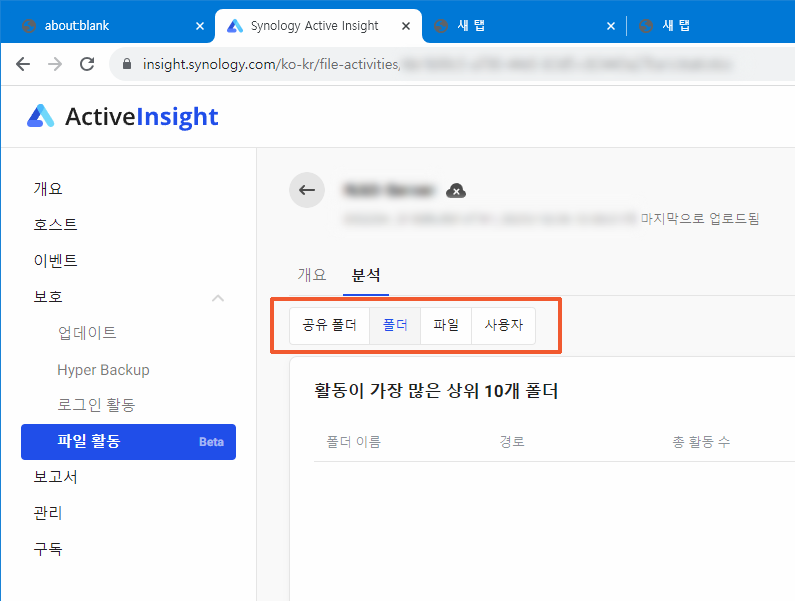

statistic.sqlite 파일은 “파일 활동”의 데이터를 저장합니다. “파일 활동”은 어느 사용자가 어느 파일을 어떻게(읽기, 쓰기, 생성, 삭제, 이름변경, 이동) 했는지를 기록합니다. 이 기록은 랜섬웨어 감지에 사용합니다. 랜섬웨어는 파일을 암호화하기 위해서 특정한 파일 활동을 반복합니다. 예를 들면 “원본 파일 읽기” > “암호화한 파일 생성” > “원본 파일 삭제” 같은 패턴입니다. 만약 이런 패턴이 모든 파일에서 발생한다면 ActiveInsight는 “어! 이거 랜섬웨어 아냐”하고 공유 폴더의 스냅샷을 자동으로 촬영합니다.

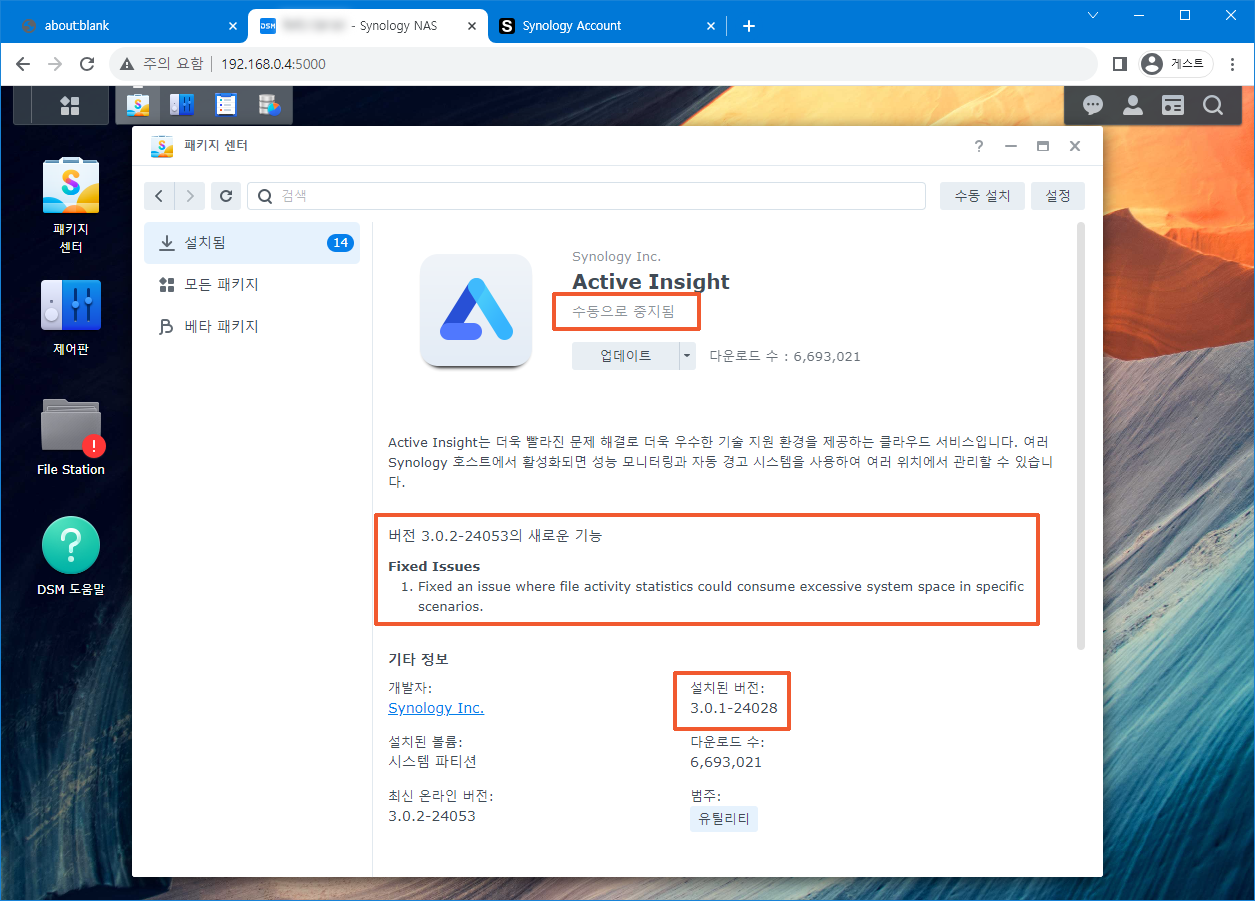

파일 활동을 계속해서 기록하다 보면 statistic.sqlite 파일의 크기가 점점 커지고 결국에는 시스템 공간을 모두 사용하게 됩니다. 현재 설치된 3.0.1-24028 버전은 이 문제를 갖고 있습니다. 최신 버전의 Active Insight는 이 문제를 해결했습니다.

버전 3.0.2-24053의 새로운 기능. 특정 시나리오에서 파일 활동 통계가 과도한 시스템 공간을 차지할 수 있는 문제를 수정했습니다.

statistic.sqlite 파일의 내용

root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# sqlite3 ./statistic.sqlite SQLite version 3.40.0 2022-11-16 12:10:08 Enter ".help" for usage hints. sqlite> .table action_counts share_action_counts user_share_action_counts file_action_counts user_action_counts folder_action_counts user_counts sqlite> select * from action_counts; 2023-10-26 12:43:54.923428046+09:00|CREATE|537 ~생략~ sqlite> select * from share_action_counts; 2023-10-26 12:52:58.626809643+09:00|2964f054-a483-4c5e-bdb1-5bcb6ba30477|MODIFY|40 ~생략~ sqlite> select * from user_share_action_counts; 2023-10-26 12:52:59.028925664+09:00|1027|user-x|2964f054-a483-4c5e-bdb1-5bcb6ba30477|ACCESS|18 ~생략~ sqlite> select * from file_action_counts; 2023-10-26 12:43:56.532622282+09:00|/volume2/dir_1/dir_2/dir_3/file.JPG|ACCESS|1 ~수만 개 생략~ sqlite> select * from user_action_counts; 2023-10-26 12:43:55.412399204+09:00|1029|user-y|MODIFY|22 ~생략~ sqlite> select * from folder_action_counts; 2023-10-26 12:52:49.649755928+09:00|/volume2/dir_4/dir_5/dir_6|CREATE|1 ~수만 개 생략~ sqlite> select * from user_counts; 2023-10-26 12:43:54.495878142+09:00|1033|user-z|1 ~생략~ sqlite> .exit root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity#

statistic.sqlite 파일에 어떤 내용을 기록하는지 확인이 가능합니다.

문제 해결 과정

- netstat -antpo

웹서버 listening 포트를 확인함. 80, 443, 5000, 5001 모두 listening 하지 않음. - tail /var/log/nginx/error_default.log

nginx 로그를 확인함. “빈 공간이 없다”는 기록이 발견됨. - systemctl status nginx.service

nginx 상태를 확인함. “서비스를 시작하지 못했다”고 나옴. - systemctl stop pkgctl-ActiveInsight.service

Active Insight를 중지함. - mv ./statistic.sqlite /volume1

statistic.sqlite 파일을 이동함. - systemctl start nginx.service

nginx를 시작함. - netstat -antpo

웹서버 listening 포트를 확인함. 80, 443, 5000, 5001 모두 listening 하고 있음. - DSM에 로그인하고 이후 과정을 진행함.

root@NAS:/var/log# netstat -antpo Active Internet connections (servers and established) Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name Timer tcp 0 0 127.0.0.1:34317 0.0.0.0:* LISTEN 17804/otel-collecto off (0.00/0/0) tcp 0 0 127.0.0.1:34318 0.0.0.0:* LISTEN 17804/otel-collecto off (0.00/0/0) tcp 0 0 127.0.0.1:33300 0.0.0.0:* LISTEN 17765/synomibresour off (0.00/0/0) tcp 0 0 127.0.0.1:33301 0.0.0.0:* LISTEN 17760/python3 off (0.00/0/0) tcp 0 0 0.0.0.0:21 0.0.0.0:* LISTEN 10729/ftpd off (0.00/0/0) tcp 0 0 127.0.0.1:33302 0.0.0.0:* LISTEN 17765/synomibresour off (0.00/0/0) tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 8717/sshd: /usr/bin off (0.00/0/0) tcp 0 0 127.0.0.1:5432 0.0.0.0:* LISTEN 12510/postgres off (0.00/0/0) tcp 0 0 127.0.0.1:161 0.0.0.0:* LISTEN 10351/snmpd off (0.00/0/0) tcp 0 0 127.0.0.1:33301 127.0.0.1:37302 TIME_WAIT - timewait (43.39/0/0) tcp 0 0 127.0.0.1:33301 127.0.0.1:37319 TIME_WAIT - timewait (54.42/0/0) tcp 0 0 127.0.0.1:33301 127.0.0.1:37272 TIME_WAIT - timewait (30.37/0/0) tcp 0 0 127.0.0.1:33301 127.0.0.1:37326 TIME_WAIT - timewait (54.39/0/0) tcp 0 0 127.0.0.1:33301 127.0.0.1:37226 TIME_WAIT - timewait (1.36/0/0) tcp 0 0 127.0.0.1:33301 127.0.0.1:37298 TIME_WAIT - timewait (42.42/0/0) ~생략 root@NAS:/var/log#

root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# tail /var/log/nginx/error_default.log ~생략~ 2023/11/13 17:50:30 [warn] 14770#14770: duplicate extension "wasm", content type: "application/wasm", previous content type: "application/wasm" in /etc/nginx/mime.types:101 2023/11/13 17:50:30 [emerg] 14770#14770: mkdir() "/var/lib/nginx/client-body" failed (28: No space left on device) 2023/11/13 17:50:30 [warn] 14771#14771: duplicate extension "wasm", content type: "application/wasm", previous content type: "application/wasm" in /etc/nginx/mime.types:101 2023/11/13 17:50:30 [emerg] 14771#14771: mkdir() "/var/lib/nginx/client-body" failed (28: No space left on device) root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# systemctl status nginx.service ● nginx.service - Nginx Loaded: loaded (/usr/lib/systemd/system/nginx.service; static; vendor preset: disabled) Drop-In: /usr/local/lib/systemd/system/nginx.service.d └─synorelay-service-handler.conf Active: failed (Result: start-limit) since Mon 2023-11-13 17:50:54 KST; 46min ago Process: 17194 ExecStart=/usr/syno/bin/synow3tool --nginx=start (code=exited, status=1/FAILURE) Process: 17164 ExecStartPre=/usr/syno/bin/synow3tool --nginx=pre-start (code=exited, status=0/SUCCESS) Nov 13 17:50:53 NAS systemd[1]: Failed to start Nginx. Nov 13 17:50:53 NAS systemd[1]: Unit nginx.service entered failed state. Nov 13 17:50:53 NAS systemd[1]: nginx.service failed. Nov 13 17:50:54 NAS systemd[1]: nginx.service holdoff time over, scheduling restart. Nov 13 17:50:54 NAS systemd[1]: start request repeated too quickly for nginx.service Nov 13 17:50:54 NAS systemd[1]: Failed to start Nginx. Nov 13 17:50:54 NAS systemd[1]: Unit nginx.service entered failed state. Nov 13 17:50:54 NAS systemd[1]: nginx.service failed. root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# systemctl -a | grep -i activein pkg-failure@ActiveInsight.service loaded inactive dead Do rollback actions after pkgctl-XXX pkgctl-ActiveInsight.service loaded active exited ActiveInsight's service unit ActiveInsight.slice loaded active active ActiveInsight's slice root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# systemctl stop pkgctl-ActiveInsight.service root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# ls -al total 896908 drwxr-xr-x 2 root root 4096 Nov 13 13:43 . drwxr-xr-x 3 root root 4096 Oct 26 12:00 .. -rw-r--r-- 1 root root 918413312 Nov 10 16:29 statistic.sqlite root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# mv ./statistic.sqlite /volume1 root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# df -h Filesystem Size Used Avail Use% Mounted on /dev/md0 2.3G 1.5G 775M 65% / devtmpfs 2.8G 0 2.8G 0% /dev tmpfs 2.9G 180K 2.9G 1% /dev/shm tmpfs 2.9G 14M 2.9G 1% /run tmpfs 2.9G 0 2.9G 0% /sys/fs/cgroup tmpfs 2.9G 608K 2.9G 1% /tmp /dev/vg1/volume_1 3.5T 439G 3.1T 13% /volume1 /dev/vg2/volume_2 7.0T 6.5T 539G 93% /volume2 root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# systemctl start nginx.service root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# systemctl status nginx.service ● nginx.service - Nginx Loaded: loaded (/usr/lib/systemd/system/nginx.service; static; vendor preset: disabled) Drop-In: /usr/local/lib/systemd/system/nginx.service.d └─synorelay-service-handler.conf Active: active (running) since Mon 2023-11-13 18:42:02 KST; 9s ago Process: 28814 ExecStartPost=/bin/sh -c [ "active" = "$(/usr/syno/bin/synosystemctl get-active-status synorelayd)" ] && /usr/syno/bin/synosystemctl reload synorelayd || exit 0 (code=exited, status=0/SUCCESS) Process: 28805 ExecStart=/usr/syno/bin/synow3tool --nginx=start (code=exited, status=0/SUCCESS) Process: 28714 ExecStartPre=/usr/syno/bin/synow3tool --nginx=pre-start (code=exited, status=0/SUCCESS) Main PID: 28811 (nginx) CGroup: /syno_dsm_internal.slice/nginx.service ├─28811 nginx: master process /usr/bin/nginx -c /etc/nginx/nginx.conf.run -g pid /run/nginx.pid; daemon on; master_process on; ├─28812 nginx: worker process └─28813 nginx: worker process Nov 13 18:42:01 NAS systemd[1]: Starting Nginx... Nov 13 18:42:01 NAS synocrtregister[28739]: synocrtregister.cpp:283 Register certificate for system/quickconnect Nov 13 18:42:01 NAS synocrtregister[28739]: synocrtregister.cpp:283 Register certificate for system/default Nov 13 18:42:01 NAS rm[28748]: uid: 0, euid: 0, arguments:["-rf" "/usr/syno/etc/certificate/system/quickconnect"] Nov 13 18:42:01 NAS rm[28749]: uid: 0, euid: 0, arguments:["-rf" "/usr/syno/etc/certificate/system/quickconnect.bak"] Nov 13 18:42:01 NAS rm[28756]: uid: 0, euid: 0, arguments:["-rf" "/usr/syno/etc/certificate/system/default"] Nov 13 18:42:01 NAS rm[28757]: uid: 0, euid: 0, arguments:["-rf" "/usr/syno/etc/certificate/system/default.bak"] Nov 13 18:42:01 NAS synocrtregister[28739]: systemd_reload.cpp:17 synosystemd: [synorelayd] reloading ... Nov 13 18:42:01 NAS synocrtregister[28739]: systemd_reload.cpp:21 synosystemd: [synorelayd] reloaded. Nov 13 18:42:02 NAS systemd[1]: Started Nginx. root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity# netstat -antpo Active Internet connections (servers and established) Proto Recv-Q Send-Q Local Address Foreign Address State PID/Program name Timer tcp 0 0 0.0.0.0:5357 0.0.0.0:* LISTEN 28811/nginx: master off (0.00/0/0) tcp 0 0 0.0.0.0:80 0.0.0.0:* LISTEN 28811/nginx: master off (0.00/0/0) tcp 0 0 0.0.0.0:21 0.0.0.0:* LISTEN 10729/ftpd off (0.00/0/0) tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 8717/sshd: /usr/bin off (0.00/0/0) tcp 0 0 127.0.0.1:5432 0.0.0.0:* LISTEN 12510/postgres off (0.00/0/0) tcp 0 0 0.0.0.0:443 0.0.0.0:* LISTEN 28811/nginx: master off (0.00/0/0) tcp 0 0 127.0.0.1:161 0.0.0.0:* LISTEN 10351/snmpd off (0.00/0/0) tcp 0 0 0.0.0.0:5000 0.0.0.0:* LISTEN 28811/nginx: master off (0.00/0/0) tcp 0 0 0.0.0.0:5001 0.0.0.0:* LISTEN 28811/nginx: master off (0.00/0/0) tcp 0 288 192.168.0.4:22 192.168.0.226:9284 ESTABLISHED 20729/sshd: user-xy on (0.07/0/0) tcp6 0 0 :::5357 :::* LISTEN 28811/nginx: master off (0.00/0/0) ~생략~ root@NAS:/usr/local/packages/@appdata/ActiveInsight/lfs/file_activity#

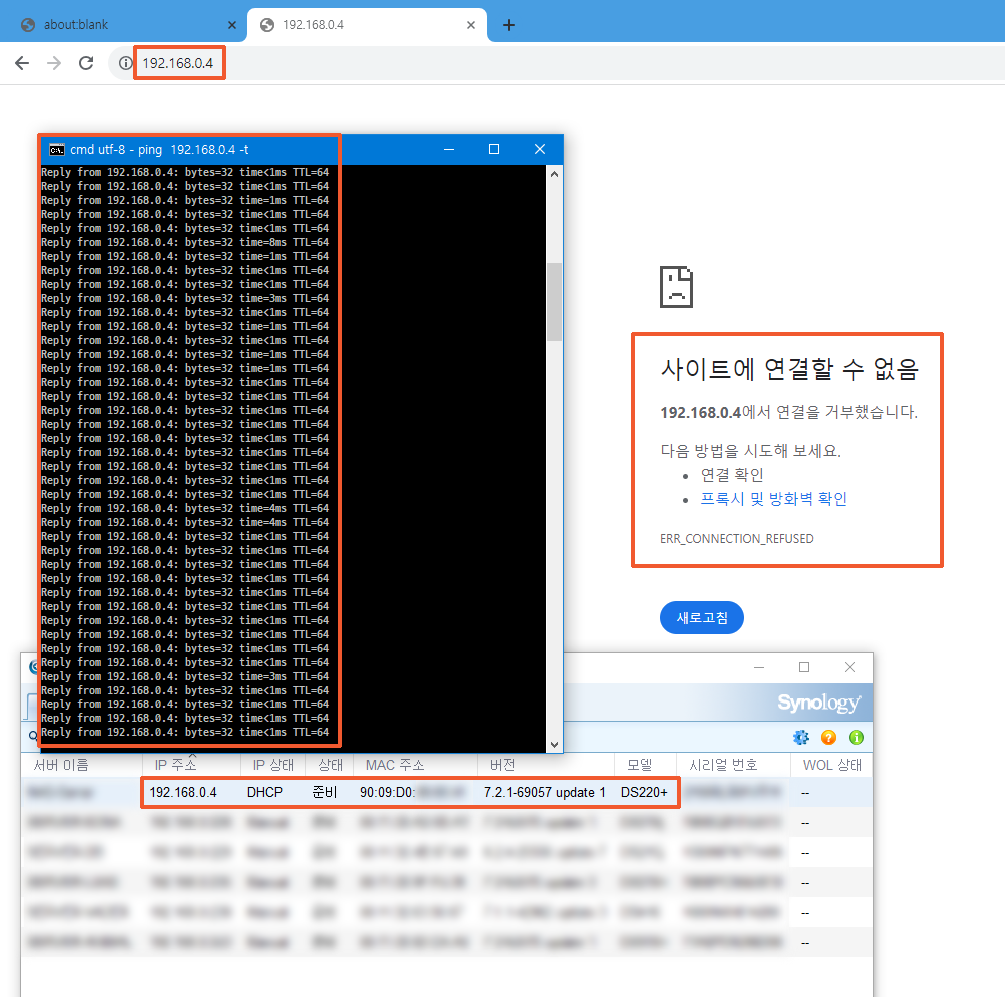

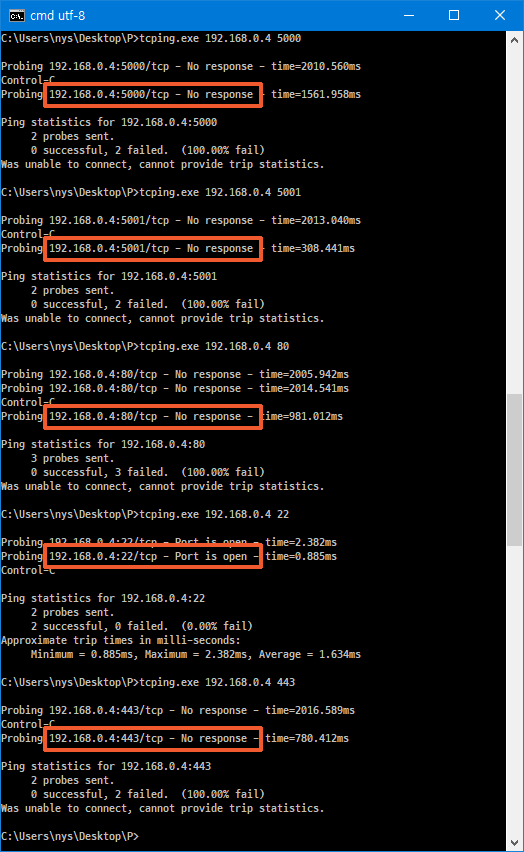

DSM이 사용하는 기본 포트 80, 443, 5000, 5001 모두 tcping 명령어에 응답하지 않습니다. 다행히 22번 포트는 열려 있어서 문제를 해결할 수 있었습니다. 만약 22번 포트가 열려있지 않으면 터미널로 접속해야 합니다.

DSM이 사용하는 기본 포트 80, 443, 5000, 5001 모두 tcping 명령어에 응답하지 않습니다. 다행히 22번 포트는 열려 있어서 문제를 해결할 수 있었습니다. 만약 22번 포트가 열려있지 않으면 터미널로 접속해야 합니다.

안녕하세요

시놀로지 DS923+ 마이그레이션 하는데 도움 요청 드립니다.

시스템 공간이 부족합니다.라고 떠서 DSM 설치가 되지 않습니다.

해결 방법이 너무 어렵네요!!!. 혹시 원격 지원 요청 드릴 수 있을까요?.

원격으로 가능합니다. 1899-8054로 전화주세요.

전화는 평일 주말 아무때나 주셔도 됩니다.

전화주시면 원격지원 할 시간을 잡고, 이후에 원격지원 해 드립니다.